By : Zhang Taehun

ระยะหลังๆ มานี้ ดูเหมือนคำว่า ‘ ดีพ เฟค ( Deepfake)” จะเป็นที่คุ้นเคยของสังคมไทยไปเสียแล้ว เมื่อเทียบกับเมื่อ 2 – 3 ปีก่อนหน้าที่อาจเป็นเพียงศัพท์เฉพาะกลุ่มของผู้สนใจเทคโนโลยี ซึ่งก็ไม่น่าแปลกใจ เพราะเริ่มมีข่าว “ โจรออนไลน์ ” ก็นำเทคโนโลยีนี้มาหลอกเหยื่อ โดยประเทศไทย เท่าที่พอจะสืบค้นข้อมูลได้ เริ่มพบรายงานมาตั้งแต่วันที่ 10 มี.ค. 2565 โดย นสพ.ผู้จัดการ รายงานข่าวผู้ใช้ TikTok ชื่อ “siripatty” โพสต์คลิปวิดีโอเตือนภัยมิจฉาชีพที่ใช้รูปภาพเป็นเจ้าหน้าที่ตำรวจ และมีการท้าให้เปิดกล้อง ซึ่งเมื่อเปิดก็พบว่าเจ้าหน้าที่ตำรวจตามภาพที่ปรากฏนั่งอยู่ แต่สิ่งที่แปลกก็คือ ขณะที่เจ้าหน้าที่ตำรวจพูดนั้น มีเพียงแค่ปากและตาที่ขยับ ซึ่งไม่สอดคล้องกับรูปของใบหน้า

จากนั้นเพียง 1 วัน ในวันที่ 11 มี.ค. 2565 เพจเฟซบุ๊ก “ กองสารนิเทศ สำนักงานตำรวจแห่งชาติ ” ออกประกาศแจ้งเตือนประชาชน “ แก๊งคอลเซ็นเตอร์ไฮเทค ใช้ Deep Fake ตัดต่อคลิปตำรวจ หลอกเอาเงิน ” โดย พ.ต.อ.ศิริวัฒน์ ดีพอ รองโฆษกสำนักงานตำรวจแห่งชาติ เปิดเผยว่า มิจฉาชีพได้ปรับเปลี่ยนวิธีการ จากที่นำคลิปวิดีโอจากการให้สัมภาษณ์ของเจ้าหน้าที่ตำรวจ ซึ่งสวมใส่หน้ากากอนามัย มาตัดต่อใส่เสียงของคนร้าย มาเป็นการใช้เทคนิค Deepfake ซึ่งเป็นการใช้เทคโนโลยี Deep Learning ในการพัฒนาระบบปัญญาประดิษฐ์ (AI) ให้สามารถตัดต่อคลิปวิดีโอหรือภาพถ่ายของบุคคลหนึ่ง ให้สามารถขยับปากตามเสียงของบุคคลอื่นได้

ยิ่งต่อมายังพบการใช้ “AI ปลอมเสียง ” ก็ยิ่งทำให้ผู้ใช้งานอินเตอร์เน็ตและสื่อสังคมออนไลน์ (Social Media) ตื่นตัว (และกังวล) มากขึ้น อาทิ รายงานจากสถานีโทรทัศน์ช่อง 8 เมื่อวันที่ 26 ก.ย. 2565 เล่าเรื่องของผู้ใช้เฟซบุ๊กรายหนึ่ง ที่เจอหมายเลขโทรศัพท์ที่ไม่คุ้นเคยโทรเข้ามา ปลายสายเป็นเสียงของเพื่อนที่รู้จักกันมานานถึง 30 ปี อ้างว่าเปลี่ยนเบอร์แล้ว ให้บันทึกเบอร์ที่โทรเข้ามาใหม่นี้ไว้แล้วลบเบอร์เก่าทิ้ง และส่งเลขบัญชีมาให้เพื่อขอยืมเงิน

ถึงตรงนี้จึงเริ่มเอะใจ เพราะชื่อบัญชีไม่ใช่ชื่อจริงของเพื่อนคนดังกล่าว บวกกับเคราะห์ดีที่ยังมีไลน์ของเพื่อนคนนี้ (ส่วนเบอร์เก่าลบทิ้งไปเพราะหลงเชื่อมิจฉาชีพ) จึงทักไปสอบถาม และได้รับคำยืนยันว่าไม่มีการทักมายืมเงินแต่อย่างใด แถมยังไม่ได้เปลี่ยนเบอร์มือถืออีกต่างหาก แล้วเมื่อนำเรื่องราวทั้งหมดไปแจ้งความ ตำรวจก็ให้ข้อมูลว่ามีเหยื่อคนอื่นๆ โดนแบบเดียวกันแล้วหลายราย

ก่อนหน้านี้ โคแฟคเคยนำเสนอเรื่องราวของทั้ง Deepfake และ AI ปลอมเสียงไปแล้ว ซึ่งในต่างประเทศ นอกจากจะหวั่นเกรงมิจฉาชีพนำไปใช้หลอกเอาทรัพย์สินของเหยื่อ ยังน่ากังวลหากวันหนึ่งถูกนำไปใช้หลอกว่าเป็นคลิปเสียงหรือคลิปวีดีโอของบุคคลสำคัญกำลังพูดบางอย่าง จนกลายเป็นสถานการณ์โกลาหลหรือก่อความรุนแรงในทางการเมืองหรือสังคมได้โดยที่เจ้าตัวไม่ได้พูดเช่นนั้นจริงแต่คนจำนวนมากหลงเชื่อไปแล้ว

เมื่อในวันที่ 17 ก.ค. 2560 สำนักข่าว BBC ของอังกฤษ รายงานกรณีคณะผู้วิจัยจาก มหาวิทยาลัยวอชิงตัน ใช้ปัญญาประดิษฐ์ (AI) สร้างเค้าโครงปากของ บารัค โอบามา อดีตประธานาธิบดีสหรัฐอเมริกา และผสานเข้ากับภาพวีดีโอของ โอบามา ที่เผยแพร่ผ่านสื่อต่างๆ โดยคณะผู้วิจัยรวบรวมมาถึง 14 ชั่วโมง สำหรับนำมาทดลองในงานนี้ และในที่สุดก็สามารถนำเสียงของบุคคลอื่นเข้าไปใส่ในใบหน้าของอดีตผู้นำสหรัฐฯ ได้อย่างแนบเนียน

นอกจากนี้ในรายงานข่าววันที่ 25 มี.ค. 2566 โดยสำนักข่าว Euronews เครือข่ายสถานีโทรทัศน์ของยุโรปที่มีสำนักงานใหญ่ในเมืองลียง ประเทศฝรั่งเศส ยกตัวอย่างการทดลองใช้เทคโนโลยีนี้เลียนแบบเสียงของ เอ็มมา วัตสัน (Emma Watson) นักแสดงสาวชาวอังกฤษ ให้อ่านออกเสียงข้อความในหนังสือ “การต่อสู้ของข้าพเจ้า (Mein Kampf)” งานเขียนของ อดอล์ฟ ฮิตเลอร์ (Adolf Hitler) ผู้นำเผด็จการนาซีเยอรมัน ในยุคสงครามโลกครั้งที่ 2

ในวันที่ 15 พ.ย. 2566 กองบัญชาการตำรวจสอบสวนกลาง แนะนำประชาชนในเบื้องต้นว่าด้วย “ การใช้เทคโนโลยี Deepfake ปลอมใบหน้าคน ” มีข้อสังเกตคือ 1.สังเกตการขยับริมฝีปาก : หากเป็นคลิปสร้างจาก AI การขยับปากของคนในคลิปจะไม่สอดคล้องกับเสียงในวิดีโอ และดูไม่เป็นธรรมชาติ2.ใบหน้า : มีลักษณะที่ผิดสัดส่วนธรรมชาติ โดยเฉพาะเมื่อก้มเงยหน้าหรือหันซ้ายหันขวา 3.สีผิวเข้มหรืออ่อนเป็นหย่อมๆ : แสงและเงาบริเวณผิวไม่สอดคล้องต่อการเคลื่อนไหว และ 4.การกะพริบตาถี่เกินไป หรือน้อยเกินไป : ดูไม่เป็นธรรมชาติ

ส่วน “ การใช้ AI ปลอมเสียง ” มีวิธีสังเกต คือ 1.จังหวะการเว้นวรรคคำพูด : เสียงพูดจาก AI จะไม่มีอารมณ์หรือความรู้สึก เสียงจึงจะไม่มีจังหวะหยุด ไม่มีเว้นวรรคจังหวะหายใจ และจะพูดประโยคยาว 2.น้ำเสียงราบเรียบ : เสียงจาก AI ที่มิจฉาชีพใช้จะมีเสียงที่ราบเรียบ ไม่มีการเน้นน้ำหนักเสียง หรือความสำคัญของคำ และ 3.คำทับศัพท์ : เสียงจาก AI จะพูดคำศัพท์เฉพาะไม่ค่อยชัด คำบางคำเวลาออกเสียง จะมีความผิดเพี้ยนไปบ้าง เนื่องจาก AI อาจยังไม่สามารถออกเสียงวรรณยุกต์ เสียงสูง-ต่ำ ได้ในบางคำ

ข้างต้นนั้นเป็นเรื่องของการสร้างข่าวลวง (Fake News) หรือข้อมูลบิดเบือน (Disinformation) แบบที่ต้องใช้เทคโนโลยีซับซ้อน ซึ่งหลายคนก็กำลังกังวลว่านับวัน AI ยิ่งพัฒนาให้ทำสิ่งเหล่านั้นได้เนียนขึ้น ทำให้การระมัดระวังทำได้ยากขึ้น แต่นั่นคือเรื่องของอนาคต ในขณะที่ปัจจุบัน ดูๆ แล้ว ข่าวลวงหรือข้อมูลบิดเบือนประเภท “ ชีพเฟค ( Cheapfake)” น่าจะเป็นสิ่งที่เราทุกคนเจอได้บ่อยกว่า

“อะไรคือชีพเฟค?” บทความ “What Are Cheapfakes (Shallowfakes)?” เผยแพร่โดย Samsung SDS บริษัทด้านเทคโนโลยีสารสนเทศและดิจิทัล ในเครือซัมซุงของเกาหลีใต้ อธิบายว่า Cheapfake หรืออีกคำหนึ่งคือ “แชลโลว์เฟค (Shallowfake)” แปลกันแบบตรงตัว คือ “การหลอกลวงหรือบิดเบือนข้อมูลด้วยวิธีการแบบบ้านๆ ง่ายๆ ไม่ซับซ้อน (Cheap แปลว่าราคาถูก ส่วน Shallow แปลว่าตื้นเขิน) อาจใช้เทคโนโลยีช่วยบ้างแต่ก็ไม่ต้องอาศัยความรู้ชั้นสูงนัก” ซึ่งต่างจาก Deepfake ที่ต้องเข้าใจเรื่อง AI และ Machine learning พอสมควร โดยวิธีการทำ Cheapfake ที่พบได้บ่อยๆ เช่น แต่งภาพด้วยโปรแกรมพื้นฐานอย่าง Photoshop , ตัดต่อวีดีโอด้วยการเร่งหรือลดความเร็ว

ภาพ01 : ภาพเก่าของ บารัค โอบามา สมัยเป็นประธานาธิบดีสหรัฐอเมริกา ตรวจเยี่ยมการพัฒนาวัคซีนโรคอีโบลา ในแล็บที่รัฐแมรีแลนด์ของสหรัฐฯ ในปี 2557 ถูกนำไปอ้างในปี 2563 ที่โลกเผชิญสถานการณ์ไวรัสโควิด-19 ระบาด ว่า เป็นภาพการไปดูโครงการเกี่ยวกับค้างคาว (สัตว์พาหะนำเชื้อโควิด-19) ที่เมืองอู่ฮั่นของจีน ในปี 2558 หรือ 5 ปีก่อนเกิดสถานการณ์โรคระบาด

หรือไม่ต้องใช้เทคโนโลยีอะไรเลย เพียงนำภาพเก่ามาโพสต์ใหม่แต่บรรยายในบริบทอื่นที่ไม่ตรงกับเหตุการณ์จริงในภาพนั้น (Re – Contextualizing) เท่านั้น โดยบทความยกตัวอย่างภาพ บารัค โอบามา อยู่ในห้องทดลองแห่งหนึ่ง ที่มาจริงๆ ของภาพนั้นอยู่ในปี 2557 สมัยที่โอบามา ยังเป็น ปธน. สหรัฐฯ ไปตรวจเยี่ยมการพัฒนาวัคซีนโรคอีโบลาในแล็บที่รัฐแมรีแลนด์ แต่ในปี 2563 ที่โลกเริ่มเผชิญสถานการณ์โรคระบาดโควิด-19 ที่เริ่มมาจากเมืองอู่ฮั่น ประเทศจีน มีการนำภาพดังกล่าวกลับมาแชร์กันอีกครั้ง แล้วบอกว่า เป็นภาพในปี 2558 ที่ ปธน.โอบามา ไปฟังบรรยายโครงการบางอย่างที่เกี่ยวกับค้างคาว (ซึ่งต่อมาจะถูกอ้างว่าเป็นพาหะนำเชื้อโควิด-19) ที่แล็บในเมืองอู่ฮั่น

ในวันที่ 18 ธ.ค. 2566 WIRED นิตยสารดังของสหรัฐฯ ที่เน้นเสนอข่าวสารด้านเทคโนโลยี เผยแพร่บทความ Worried About Political Deepfakes? Beware the Spread of ‘Cheapfakes’ ระบุว่า ในขณะที่แวดวงการเมืองทั่วโลก (โดยเฉพาะในสหรัฐฯ ที่กำลังนับถอยหลังสู่การเลือกตั้งประธานาธิบดีในช่วงปลายปี 2567) กำลังกังวลเกี่ยวกับข้อมูลหรือเนื้อหาที่สร้างโดยปัญญาประดิษฐ์ (Generative AI) แต่การเผยแพร่ข้อมูลที่ทำให้เกิดความเข้าใจผิดทำได้ง่ายกว่าด้วยการติดป้ายกำกับรูปภาพ วิดีโอ หรือคลิปเสียงผิดบริบทเพื่อบอกเป็นนัยว่ามาจากเวลาหรือสถานที่อื่น หรือแก้ไขสื่อเพื่อให้ดูเหมือนมีบางอย่างเกิดขึ้นทั้งที่เรื่องนั้นไม่ได้เกิดขึ้นจริง

บทความของ WIRED ยกตัวอย่างในปี 2563 มีคลิปวีดีโอ แนนซี เพโลซี (Nancy Pelosi – ปัจจุบันเป็นประธานสภาผู้แทนราษฎรของสหรัฐฯ) เป็นคลิปจริงไม่ได้ใช้ AI ทำขึ้น แต่ใช้วิธีตัดต่อให้เล่นด้วยความเร็วช้าลง เพื่อให้ผู้ที่ชมคลิปเข้าใจว่านักการเมืองผู้นี้อยู่ในอาการมึนเมา ซึ่งเมื่อดูการกำกับดูแลของแต่ละแพลตฟอร์ม พบว่า ในขณะที่ X (ทวิตเตอร์) TikTok และยูทูบ ลบคลิปดังกล่าวออกจากระบบ แต่เฟซบุ๊กไม่ได้ลบออกโดยทำเพียงมีคำเตือนว่า “มีเนื้อหาบางส่วนเป็นเท็จ” ซึ่งบทความนี้มองว่า เนื้อหาทำนองนี้ยังคงมีผลกระทบอย่างมากหากได้รับอนุญาตให้เผยแพร่บนแพลตฟอร์มสื่อสังคมออนไลน์

สำนักข่าวออนไลน์ในสหรัฐฯ อย่าง Slate เผยแพร่รายงาน Beware the Cheapfakes เมื่อวันที่ 12 มิ.ย. 2562 เตือนประชาชนว่า แม้ Deepfake จะเป็นเทคโนโลยีที่น่ากังวล แต่ความเสียหายหลายๆ ครั้งก็เกิดจากเทคนิคพื้นๆ แบบ Cheapfake โดยยกตัวอย่างคลิปวีดีโอนักการเมืองอเมริกัน แนนซี เพโลซี ที่ดูเหมือนมีอาการมึนเมา แต่ในความเป็นจริงคือคลิปนี้ถูกตัดต่อด้วยการทำให้เล่นด้วยความเร็วช้าลง ซึ่งท้าทายการตรวจจับและหักล้างเพราะเป็นคลิปวีดีโอจริงที่ผ่านการแก้ไขดัดแปลงเพียงเล็กน้อย

คลิปวีดีโอที่ถูกตั้งชื่อว่า Drunk Pelosi ถูกโพสต์บนเพจเฟซบุ๊กหนึ่งที่มียอดผู้ติดตามถึง 35,000 บัญชี บรรยายว่า แนนซี เพโลซีพูดไม่ชัดและมีกิริยาอาการเหมือนคนเมา อย่างไรก็ตาม เมื่อเปรียบเทียบกับวิดีโออื่นจากเหตุการณ์เดียวกัน แม้แต่คนที่ไม่ใช่ผู้เชี่ยวชาญก็ยังดูออกว่าวิดีโอถูกลดความเร็วลง ถึงกระนั้นก็น่าเป็นห่วง เพราะคลิปบิดเบือนนี้ถูกนำไปไปขยายความต่อโดย โดนัลด์ ทรัมป์ (Donald Trump) ประธานาธิบดีในขณะนั้น รวมถึงนักการเมืองคนอื่นๆ ของพรรครีพับลิกัน อันเป็นขั้วการเมืองตรงข้ามกับพรรคเดโมแครตที่ เพโลซี สังกัดอยู่

ภาพ 02 : โพสต์คำเตือนจากศูนย์ต่อต้านข่าวปลอม กระทรวงดิจิทัลเพื่อเศรษฐกิจและสังคม กรณีมีการแชร์ภาพที่อ้างว่า พล.อ.ประยุทธ์ จันทร์โอชา นายกรัฐมนตรีในขณะนั้น ลงพื้นที่ช่วงเดือน มี.ค. 2563 ปลุกคนไทยสู้ภัยโควิด – 19 ว่าเป็นข่าวลวง โดยเป็นภาพเก่าที่ พล.อ.ประยุทธ์ ไปลงพื้นที่ถนนเยาวราช ภาพ 03 : เว็บไซต์ นสพ.ผู้จัดการ รายงานข่าว วันที่ 15 ธ.ค. 2562 พล.อ.ประยุทธ์ จันทร์โอชา นายกรัฐมนตรีในขณะนั้น ลงพื้นที่ถนนเยาวราชเพื่อเยี่ยมชมกิจกรรมถนนคนเดินและสตรีทฟู้ด ซึ่งหลังจากนั้นไม่กี่เดือน จะมีภาพจากงานนี้ถูกนำไปใช้อ้างว่า พล.อ.ประยุทธ์ ลงพื้นที่กลางกรุงเทพฯ ปลุกคนไทยสู้ภัยโควิด – 19

กลับมาที่ประเทศไทย Cheapfake ที่น่าจะผ่านหูผ่านตากันบ่อยๆ คงเป็นเรื่องของภาพเก่าเล่าใหม่อย่างผิดบริบท (Re – Contextualizing) ยกตัวอย่างจากที่ ศูนย์ต่อต้านข่าวปลอม กระทรวงดิจิทัลเพื่อเศรษฐกิจและสังคม เคยรวบรวมไว้ เช่น ในเดือน มี.ค. 2563 ที่ประเทศไทยเริ่มเผชิญสถานการณ์โรคระบาดโควิด – 19 มีการแชร์ภาพ พล.อ.ประยุทธ์ จันทร์โอชา นายกรัฐมนตรีในขณะนั้น ลงพื้นที่ปราศรัยบนท้องถนนใจกลางกรุงเทพฯ ปลุกพลังคนไทยสู้ภัยไวรัสโคโรนา แต่เรื่องนี้เป็นข่าวลวง เพราะในความเป็นจริง ภาพดังกล่าวถูกถ่ายในวันที่ 15 ธ.ค. 2562 ซึ่ง พล.อ.ประยุทธ์ ไปลงพื้นที่ถนนเยาวราชเพื่อเยี่ยมชมกิจกรรมถนนคนเดินและสตรีทฟู้ด

หรือในช่วงปี 2565 ที่มีการแชร์ภาพปั๊ม ปตท. ใน สปป.ลาว ถูกไฟไหม้ซึ่งอ้างว่ามีการวางเพลิงเกิดขึ้น วนไป – มาอยู่หลายครั้ง ในความเป็นจริงภาพที่แชร์กันเป็นเหตุการณ์ในประเทศไทยเมื่อหลายปีก่อน เช่น ภาพรถกระบะถูกไฟไหม้ เหตุเกิดที่ปั๊ม ปตท. ละงูปิโตรเลียม ริมถนนละงู-ปากบารา เขตเทศบาลตำบลกำแพง อ.ละงู จ.สตูล วันที่ 22 พ.ย. 2560 โดยพบสื่อไทย 2 สำนัก คือ นสพ.ไทยรัฐ และ นสพ.ผู้จัดการ รายงานข่าวนี้ โดยในส่วนของ นสพ.ไทยรัฐ ยังรายงานด้วยว่า สาเหตุการเกิดไฟไหม้ครั้งนี้ เกิดจากขณะคนงานกำลังใช้เครื่องสูบน้ำมันแบบใช้มือหมุน สูบน้ำมันอี 20 ลงถัง ได้เกิดการเสียดสีบริเวณปากถัง 200 ลิตร และเกิดประกายไฟขึ้นมาจนทำให้เกิดไฟไหม้

เทคนิค Cheapfake ยังถูกมิจฉาชีพนำไปใช้หลอกให้เหยื่อ (โดยเฉพาะที่เป็นคน “ใจดี – ใจบุญ” ชอบสร้างกุศลบริจาคเงิตช่วยเหลือผู้ตกทุกข์ได้ยาก) โอนเงินบริจาคได้ด้วย รายงานข่าวเมื่อวันที่ 16 มี.ค. 2564 มีคุณแม่ท่านหนึ่งได้ออกมาเปิดเผยเป็นอุทาหรณ์ว่า ตนได้เข้าแจ้งความที่ สภ.บึงสามพัน จ.เพชรบูรณ์ หลังพบมีมิจฉาชีพ นำภาพเก่าของลูกชายที่เข้ารับการรักษาโรคปากแหว่งเพดานโหว่เมื่อเดือน มิ.ย. 2563 ไปโพสต์ขอรับบริจาคนม ผ้าอ้อมหรือปัจจัยช่วยค่าใช้จ่ายในการรักษา พร้อมระบุเลขบัญชีธนาคาร โดยอ้างว่าเด็กในภาพเป็นโรคหัวใจหอบ ซึ่งคุณแม่ท่านนี้ยืนยันว่า ปัจจุบันลูกชายตน (หรือเด็กที่ถูกนำภาพไปแอบอ้าง) สุขภาพแข็งแรงดี

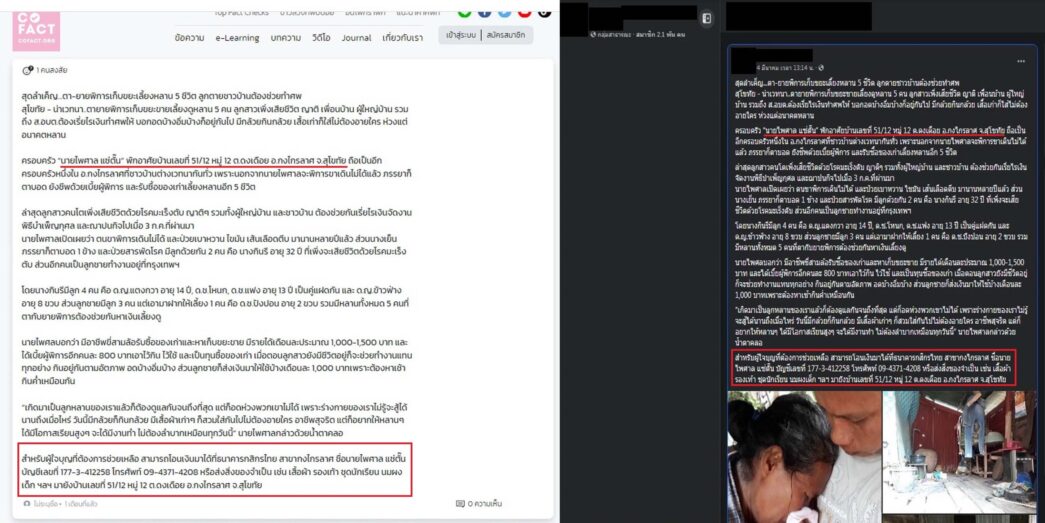

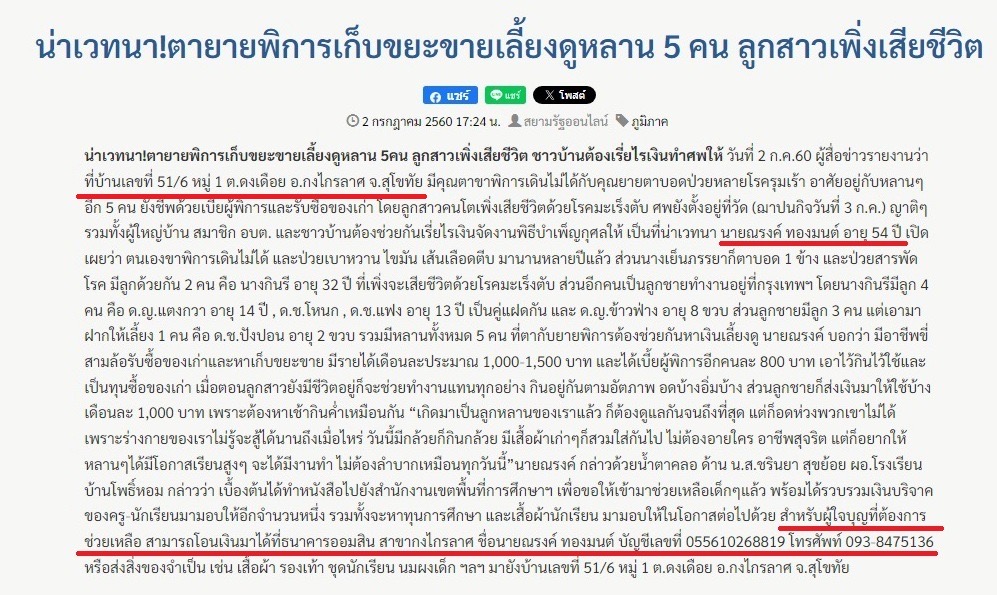

ภาพ 04 : ข้อความและภาพเรื่องตา-ยายพิการเก็บขยะเลี้ยงหลาน 5 ชีวิต ที่สอบถามเข้ามาในระบบของ Cofact และที่แชร์ทางกลุ่มเฟซบุ๊ก ในเดือน ก.พ. และ มี.ค. 2567 ระบุผู้ต้องการความช่วยเหลือคือ นายไพศาล แซ่ตั๊น ภาพ 05 : ข่าวจาก นสพ.สยามรัฐ เมื่อวันที่ 2 ก.ค. 2560 เนื้อข่าวเดียวกันกับที่ถูกนำมาแชร์ในอีกเกือบ 7 ปีให้หลัง ยกเว้นชื่อของผู้ที่ต้องการความช่วยเหลือ คือนายณรงค์ ทองมนต์

ภาพ 06 : ข่าวจาก นสพ. ผู้จัดการ เมื่อวันที่ 4 ก.ค. 2560 เนื้อข่าวและภาพประกอบเดียวกันกับที่ถูกนำมาแชร์ในอีกเกือบ 7 ปีให้หลัง ยกเว้นชื่อของผู้ที่ต้องการความช่วยเหลือ คือนายณรงค์ ทองมนต์

นอกจากการใช้ภาพเก่าแล้ว “ การใช้ข่าวเก่าแบบล อกมาทั้งหมด แต่เปลี่ยนชื่อและ บัญชี ธนาคาร ผู้รับบริจาค ” ก็ต้องระมัดระวัง โดยเมื่อเดือน ก.พ. 2567 มีผู้ส่งข้อความเข้ามาถามในระบบฐานข้อมูลของ Cofact เป็นเรื่องของ “ ตา-ยายพิการเก็บขยะเลี้ยงหลาน 5 ชีวิต ” ในพื้นที่ ต.ดงเดือย อ.กงไกรลาศ จ.สุโขทัย ซึ่งเมื่อลองนำส่วนหนึ่งของข้อความไปค้นหาดู ยังพบการแชร์ในกลุ่มเฟซบุ๊กเมื่อวันที่ 4 มี.ค. 2567 อย่างไรก็ตาม เมื่อทดลองนำข้อความที่โพสต์ไปค้นหาในอินเตอร์เน็ต กลับพบว่าทั้งภาพและเนื้อหา ไปตรงกับข่าวที่มีสื่ออย่างน้อย 2 สำนัก รายงานเมื่อเกือบ 7 ปีก่อน

โดย นสพ.สยามรัฐ และ นสพ.ผู้จัดการ เคยรายงานข่าวนี้เมื่อวันที่ 2 และ 4 ก.ค. 2560 ตามลำดับ จะแตกต่างก็มีเพียงข่าวจากหนังสือพิมพ์ 2 ฉบับข้างต้น ระบุครอบครัวที่ได้รับความเดือดร้อน คือ นายณรงค์ ทองมนต์ บัญชีเลขที่ 055610268819 ธนาคารออมสิน สาขากงไกรลาศ หมายเลขโทรศัพท์ 093-8475136 ในขณะที่ข้อความซึ่งแชร์กันบนโลกออนไลน์ ตามเวลาล่าสุดที่พบคือเดือน ก.พ. และ มี.ค. 2567 ได้เปลี่ยนเป็นชื่อ นายไพศาล แซ่ตั๊น บัญชีเลขที่ 177-3-412258 ธนาคารกสิกรไทย สาขากงไกรลาศ หมายเลขโทรศัพท์ 09-4371-4208

(หมายเหตุ : กรณีข่าวตา-ยายพิการเก็บขยะเลี้ยงหลาน 5 ชีวิต ในพื้นที่ ต.ดงเดือย อ.กงไกรลาศ จ.สุโขทัย ผู้เขียนมิได้เจตนากล่าวหาบุคคลที่ปรากฏชื่อว่าเป็นมิจฉาชีพ เพียงแต่พบข้อสงสัยว่าด้วยเนื้อหาและภาพข่าวเดียวกันแต่ถูกเผยแพร่ส่งต่อในต่างห้วงเวลาและมีการแก้ไขชื่อ เลขบัญชีธนาคาร รวมถึงหมายเลขโทรศัพท์ของผู้ที่ต้องการความช่วยเหลือ ซึ่งถือว่าเป็นข้อน่าสงสัย จึงหยิบยกขึ้นมาเพื่อเป็นกรณีศึกษา ทั้งนี้ ผู้เขียนพร้อมเผยแพร่คำชี้แจงเพิ่มเติมหากผู้ถูกพาดพิงชี้แจงเข้ามา)

ยังมีกรณีที่เทคนิค Cheapfake ไม่ได้ใช้เพื่อหลอกคนบนโลกออนไลน์ แต่นำไปใช้ตบตาเจ้าหน้าที่ตำรวจบนท้องถนน โดยเมื่อวันที่ 27 ธ.ค. 2566 สถานีโทรทัศน์ช่อง 7 รายงานข่าวตำรวจจับผู้ต้องหา เปิดเพจเฟซบุ๊กจำหน่ายป้ายทะเบียนรถปลอมและป้ายแสดงการเสียภาษีประจำปี (ป้ายวงกลม) ปลอม โดยผู้ต้องหารับสารภาพว่า ป้ายทะเบียนปลอมนั้นซื้อมาขายต่อ แต่ป้ายแสดงการเสียภาษีประจำปี (ป้ายวงกลม) ปลอม ทำขึ้นเองโดยใช้โปรแกรม Photoshop ใช้เวลาทำประมาณ 3 นาที ต้นทุนไม่ถึง 10 บาท แต่ขายได้ราคาสูงถึง1,300 – 1,500 บาท

โดยสรุปแล้ว “ แม้เราจะกังวลกับเทคโนโลยีใหม่ๆ อย่าง AI หรือ Deepfake ที่ทำให้ข่าวลวงหรือข้อมูลบิด เบือนทำได้แนบเนียนจับผิดได้ยาก แต่ก็อย่าลืมหรือ อย่า ประเมินอันตรายของ Cheapfake ต่ำเกินไป ” เพราะอย่างหลังนี้เจอได้บ่อยๆ เนื่องจากสามารถทำได้ง่ายๆ ไม่ต้องอาศัยความรู้ซับซ้อน และหากมันไป “ กระตุ้นอารมณ์ ” บางอย่างในตัวเรา เมื่อนั้นไม่ว่าใครก็อาจเผลอ “ เชื่อ ” และ “ แชร์ ” ข่าวนั้นต่อไปได้

อย่างข่าวอดีตนายกฯ พล.อ.ประยุทธ์ ลงพื้นที่ปลุกสู้ภัยโควิด-19 ท่ามกลางผู้คนห้อมล้อมหนาแน่น ก็อาจกระตุ้นได้ทั้งคนที่ชอบ-ไม่ชอบ พล.อ.ประยุทธ์ ให้ตีความและแชร์ออกไปในมุมที่ต่างกัน กลายเป็นความขัดแย้งทะเลาะเบาะแว้งขึ้นมาในหมู่ประชาชน หรือข่าวตา-ยายชีวิตรันทดเปิดรับบริจาค หากรีบโอนไปทันทีด้วยใจสงสารโดยยังไม่ทันได้ตรวจสอบ เงินนั้นก็อาจไปไม่ถึงมือของผู้ที่ตกทุกข์ได้ยากและต้องการความช่วยเหลือจริงๆ

“ ตั้งสติก่อนเชื่อ..เช็คให้ชัวร์ก่อนแชร์ ( และโอนเงิน) ” ยังคงเป็นหลักปฏิบัติที่ต้องยึดให้มั่นเสมอ !!!

-/-/-/-/-/-/-/-/-/-/-

อ้างอิง

https://mgronline.com/onlinesection/detail/9650000023797 (แก๊งคอลเซ็นเตอร์” ก้าวไปอีกขั้น ใช้ “deepfake” ภาพตำรวจขยับแค่ปากหลอกเหยื่อ : ผู้จัดการ 10 มี.ค. 2565)

https://www.facebook.com/photo/?fbid=5217890471594448&set=a.1047112478672289 (ตร. เตือน แก๊งคอลเซ็นเตอร์ไฮเทค ใช้ Deep Fake ตัดต่อคลิปตำรวจ หลอกเอาเงิน : กองสารนิเทศ สำนักงานตำรวจแห่งชาติ 11 มี.ค. 2565)

https://www.thaich8.com/news_detail/112669 (เตือนภัย! มิจฉาชีพคิดกลโกงใหม่ ใช้ AI ปลอมเสียงเป็นคนคุ้นเคยโทรหลอกยืมเงิน : ช่อง8 26 ก.ย. 2565)

https://www.bbc.com/news/av/technology-40598465 (Fake Obama created using AI tool to make phoney speeches : BBC 17 ก.ค. 2560)

https://blog.cofact.org/deepfake2022/ (‘DEEPFAKE’อีกระดับของข่าวปลอม ‘หลอกเนียน-ลวงเหมือน-สกัดยาก’รู้อีกทีเป็นเหยื่อ : Cofact 13 มี.ค. 2565)

https://www.euronews.com/next/2023/03/25/audio-deepfake-scams-criminals-are-using-ai-to-sound-like-family-and-people-are-falling-fo (Audio deepfake scams: Criminals are using AI to sound like family and people are falling for it : Euronews 25 มี.ค. 2566)

https://blog.cofact.org/specialreport4-66/ (‘ปลอมเสียงคนรู้จัก’ เทคโนโลยี‘AI’ก้าวหน้า..เอื้อ ‘มิจฉาชีพ’ สวมรอยหลอกเหยื่อแนบเนียน : Cofact 9 พ.ค. 2566)

https://www.facebook.com/photo/?fbid=364219319444945&set=a.127278969805649 (ระวัง Deepfake สู่ Fake News วิธีสังเกตคนจริง หรือ AI : ตำรวจสอบสวนกลาง 15 พ.ย. 2566)

https://www.samsungsds.com/en/insights/what-are-cheapfakes.html (What Are Cheapfakes (Shallowfakes)? : Samsung SDS : 23 พ.ค. 2565)

https://www.wired.com/story/meta-youtube-ai-political-ads/ (Worried About Political Deepfakes? Beware the Spread of ‘Cheapfakes’ : WIRED 18 ธ.ค. 2566)

https://slate.com/technology/2019/06/drunk-pelosi-deepfakes-cheapfakes-artificial-intelligence-disinformation.html (Beware the Cheapfakes : Slate 12 มิ.ย. 2562)

https://www.facebook.com/AntiFakeNewsCenter/photos/ข่าวปลอม-อย่าแชร์-นายกฯ-ลงพื้นที่ปลุกคน-สู้-covid-19-กลางถนนตามที่ได้มีข่าวปรากฎ/205219940912187/?locale=it_IT&paipv=0&eav=AfY6ugC3AEHqWGJt9fjHB8xovtbNPBpNnOrmekHIkXQtaPJ1Z3CKkbNZ0S-ol8jISq4&_rdr (ข่าวปลอม อย่าแชร์! นายกฯ ลงพื้นที่ปลุกคน สู้ COVID-19 กลางถนน : ศูนย์ต่อต้านข่าวปลอมฯ 23 มี.ค. 2563)

https://mgronline.com/politics/detail/9620000119525 (“บิ๊กตู่” ลุยถนนคนเดินเยาวราช ประกาศสู้ ปชช.ตะโกนเชียร์ลุง : ผู้จัดการ 15 ธ.ค. 2562)

https://www.antifakenewscenter.com/ความสงบและความมั่นคง/ข่าวปลอม-อย่าแชร์-มีการ-3/ (ข่าวปลอม อย่าแชร์! มีการเผาปั๊มน้ำมันปตท. ในประเทศลาว : ศูนย์ต่อต้านข่าวปลอมฯ 2 ธ.ค. 2565)

https://www.thairath.co.th/news/society/1133465 (นาทีระทึก! คลิปไฟไหม้รถกระบะในปั๊มน้ำมัน อ.ละงู เสียวระเบิด : ไทยรัฐ 23 พ.ย. 2560)

https://mgronline.com/south/detail/9600000117842 (เพลิงไหม้กระบะวอดทั้งคันขณะนำน้ำมันลงท่อในปั๊ม ปตท.ละงู กลางเมืองสตูล : ผู้จัดการ 22 พ.ย. 2560)

https://www.thairath.co.th/news/local/northeast/2051281 (แม่อุ้มลูกน้อยแจ้งจับโจรในโซเชียล เอารูปเด็กไปโพสต์ ขอรับบริจาค : ไทยรัฐ 16 มี.ค. 2564)

https://cofact.org/article/28nr75gxky3s9

https://siamrath.co.th/n/18721 (น่าเวทนา!ตายายพิการเก็บขยะขายเลี้ยงดูหลาน 5 คน ลูกสาวเพิ่งเสียชีวิต : สยามรัฐ 2 ก.ค. 2560)

https://mgronline.com/local/detail/9600000067779 (สุดลำเค็ญ…ตา-ยายพิการเก็บขยะเลี้ยงหลาน 5 ชีวิต ลูกตายชาวบ้านต้องช่วยทำศพ : ผู้จัดการ 4 ก.ค. 2560)

https://news.ch7.com/detail/694950 (จับพ่อค้าหัวใส ทำป้ายปลอมขาย : ช่อง 7 27 ธ.ค. 2566)