โลกออนไลน์ที่ไม่รู้ว่าอะไรจริง – ลวงอีกต่อไป เมื่อใครๆ ก็เข้าถึง‘AI’ทำภาพ-คลิปวิดีโอได้แนบเนียน

By : บัญชา จันทร์สมบูรณ์

“วันนี้ผมขึ้นรถไฟครั้งแรกในชีวิตครับ ไม่คิดว่าจะเจอแบบนี้ ตอนรถแล่นมาจู่ๆ เครนก็ล้มทับเสียงดังมาก คนกรี๊ดกันเต็มไปหมด ผมเองโดนกระจกบาดคิ้วแตก หัวแตก”

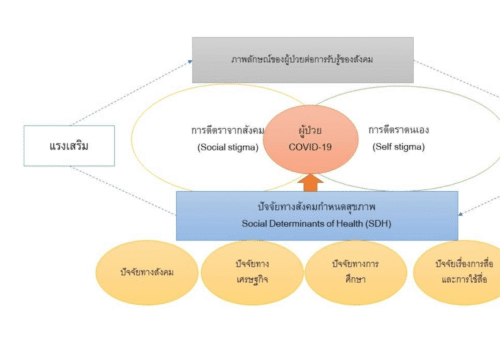

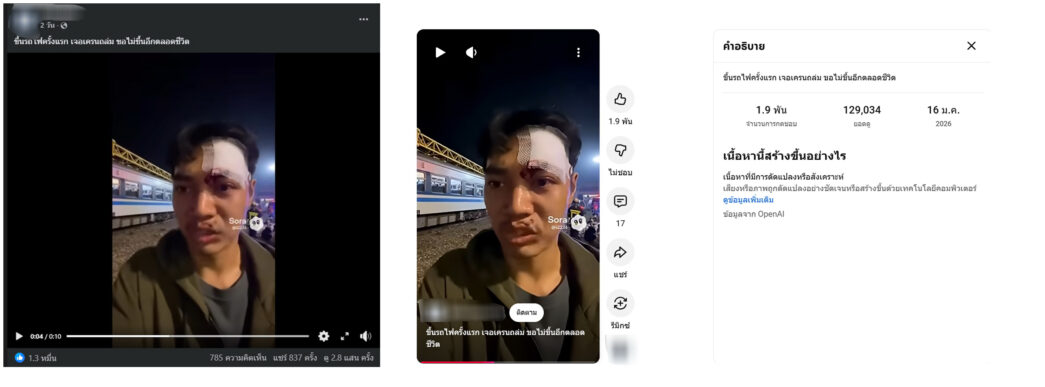

คลิปวิดีโอความยาว 10 วินาที เป็นภาพชายหนุ่มในสภาพมีผ้าก๊อซปิดแผลบริเวณหน้าผาก ถูกเผยแพร่ผ่านช่องทางสื่อสังคมออนไลน์อย่างเฟซบุ๊กและยูทูบ เมื่อวันที่ 16 ม.ค. 2569 หรือ 2 วันหลังเหตุโศกนาฎกรรมเครนขนาดใหญ่ในโครงการก่อสร้างรถไฟความเร็วสูงพังถล่มลงมาทับขบวนรถไฟด่วนพิเศษดีเซลราง (สปรินเตอร์) ขบวนที่ 21 ขณะกำลังมุ่งหน้าสู่ จ.อุบลราชธานี บริเวณ กม.รถไฟที่ 220 หลัก 9 บ้านถนนคต ต.สีคิ้ว อ.สีคิ้ว จ.นครราชสีมาเมื่อวันที่ 14 ม.ค. 2569 ส่งผลให้มีผู้เสียชีวิตถึง 30 ราย และบาดเจ็บ 69 ราย

คลิปดังกล่าวมีการแชร์ต่อเป็นจำนวนมาก ความเห็นส่วนใหญ่เป็นไปในทางเห็นใจผู้ประสบเหตุ แต่ก็มีบ้างเช่นกันที่ตั้งข้อสงสัยว่า “เป็นคลิปวิดีโอจริงหรือถูกสร้างขึ้นด้วยเทคโนโลยีปัญญาประดิษฐ์ (AI)” เนื่องด้วยปรากฏโลโก้ “Sora” เครื่องมือปัญญาประดิษฐ์แบบรู้สร้าง (Generation AI) ที่พัฒนาโดย “OpenAI” เจ้าของเดียวกับ AI แชทบอทถามอะไรก็ตอบได้อย่าง “Chat GPT” โดย Sora นั้นเปิดตัวอย่างเป็นทางการเมืองวันที่ 9 ก.ย. 2567

– Sora คืออะไร? : ในการเปิดตัวเมื่อวันที่ 9 ธ.ค. 2567 ทาง OpenAI ใช้ชื่อว่า “Sora is here” ซึ่งเป็นการเปิดตัวหลังจากรายงานความคืบหน้าไปเมื่อเดือน ก.พ. 2567 เป็นผลิตภัณฑ์สำหรับผู้ใช้ ChatGPT Plus และ Pro โดยผู้ใช้สามารถสร้างวิดีโอความละเอียดสูงสุด 1080p ความยาวสูงสุด 20 วินาที และในอัตราส่วนภาพแบบไวด์สกรีน แนวตั้ง หรือสี่เหลี่ยมจัตุรัส ผู้ใช้งานสามารถนำเนื้อหาของตนเองมาขยาย ปรับแต่ง และผสมผสาน หรือสร้างเนื้อหาใหม่ทั้งหมดจากข้อความได้

สำนักข่าวรอยเตอร์ รายงานข่าวการเปิดตัวของ Sora AI ว่า OpenAI จะบล็อกการสร้างและการอัปโหลดเนื้อหาที่ก่อให้เกิดความเสียหาย เช่น สื่อลามกอนาจารเด็ก และวิดีโอปลอมแปลงทางเพศบน Sora เพื่อป้องกันการนำไปใช้ในทางที่ผิด นอกจากนั้น การอัปโหลดของผู้ใช้จะถูกจำกัดในช่วงเปิดตัว แต่ OpenAI ตั้งใจที่จะขยายฟีเจอร์นี้ไปยังผู้ใช้มากขึ้นเมื่อได้ปรับปรุงมาตรการป้องกันวิดีโอปลอมแปลงทางเพศให้ดียิ่งขึ้นแล้ว

อีก 1 ปีต่อมา ในวันที่ 30 ก.ย. 2568 ทาง OpenAI ก็ได้เปิดตัว “Sora 2” โดยหัวข้อ “Sora 2 is here” บนเว็บไซต์ openai.com ระบุว่า เป็นการปรับปรุงเพื่อให้สามารถสร้างวิดีโอที่โมเดลวิดีโอรุ่นก่อนๆ ทำได้ยากมาก หรือบางอย่างแทบจะทำไม่ได้เลย ในฐานะระบบสร้างวิดีโอและเสียงสำหรับการใช้งานทั่วไป โมเดลนี้สามารถสร้างเสียงพื้นหลัง เสียงพูด และเอฟเฟกต์เสียงที่ซับซ้อนได้อย่างสมจริง อีกทั้งยังสามารถนำองค์ประกอบจากโลกจริงใส่เข้าไปใน Sora 2 ได้โดยตรง

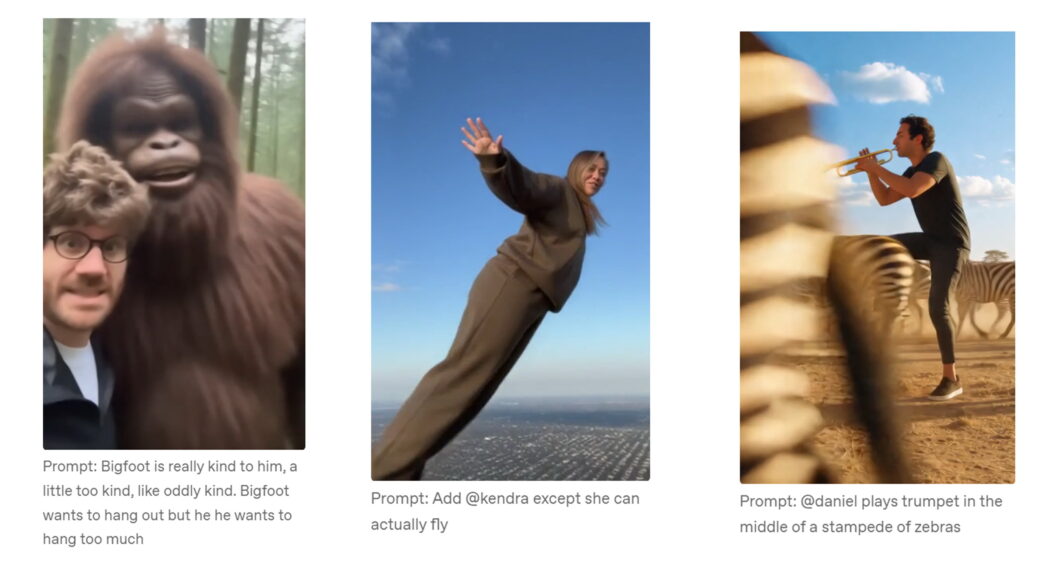

“ตัวอย่างเช่น เมื่อโมเดลดูวิดีโอของเพื่อนร่วมงานเรา มันสามารถใส่บุคคลนั้นเข้าไปในโลกที่ Sora สร้างขึ้น พร้อมจำลองรูปลักษณ์และเสียงออกมาได้อย่างแม่นยำ ความสามารถนี้เป็นความสามารถทั่วไป และสามารถนำใช้ได้กับมนุษย์ สัตว์ หรือวัตถุก็ได้ โมเดลนี้ยังห่างไกลจากความสมบูรณ์และมีข้อผิดพลาดมากมาย แต่ก็พิสูจน์ได้ว่าการเพิ่มขนาดเครือข่ายประสาทเทียมด้วยข้อมูลวิดีโอจะช่วยให้เราเข้าใกล้การจำลองความจริงมากขึ้นเรื่อยๆ” ข้อมูลจาก OpenAI ระบุ

ที่มา : OpenAI

– มีข้อกำหนดอะไรในการใช้งาน Sora AI บ้าง? : ทาง Open AI ได้ระบุข้อกำหนดไว้ในหัวข้อ “Launching Sora responsibly” เมื่อวันที่ 30 ก.ย. 2568 ดังนี้ 1.การแยกแยะเนื้อหาที่สร้างโดย AI (Distinguishing AI content) คลิปวิดีโอที่สร้างด้วย Sora จะมีสัญญาณบ่งชี้แหล่งที่มาทั้งที่มองเห็นได้และมองไม่เห็น ในช่วงเปิดตัว วิดีโอทั้งหมดจะมีลายน้ำที่มองเห็นได้ นอกจากนี้ วิดีโอ Sora ทุกเรื่องยังฝังข้อมูลเมตา C2PA ซึ่งเป็นลายเซ็นมาตรฐานอุตสาหกรรม และยังมีเครื่องมือค้นหาภาพและเสียงย้อนกลับภายในองค์กรที่สามารถติดตามวิดีโอไปยัง Sora ได้อย่างแม่นยำสูง โดยต่อยอดจากระบบที่ประสบความสำเร็จจากการสร้างภาพ ChatGPT และ Sora 1

2.การใช้ภาพเหมือนโดยได้รับความยินยอม (Consent-based likeness) เป็นมาตรการป้องกันเพื่อให้แน่ใจว่าภาพและเสียงของผู้ใช้งานจะถูกใช้โดยได้รับความยินยอมจากผู้ใช้งานนั้นเองผ่านทางฟีเจอร์ Cameo ของ Sora ซึ่งเป็นฟีเจอร์ที่ทำให้วิดีโอ AI มีชีวิต โดยระบบสามารถจำลองรูปลักษณ์ ท่าทาง และอารมณ์จากต้นแบบที่อัปโหลดได้อย่างแม่นยำ เพียงแค่ผู้ใช้งานใช้คำสั่งการใช้งาน(Prompt) กำหนด โดยไม่ต้องพึ่งนักแสดงหรือทีมถ่ายทำจริงอีกต่อไป นอกจากนี้เจ้าของภาพและเสียงยังสามารถเพิกถอนสิทธิ์การเข้าถึงได้ตลอดเวลา OpenAI ยังใช้มาตรการเพื่อบล็อกภาพบุคคลสาธารณะ (ยกเว้นผู้ที่ใช้ฟีเจอร์ Cameo แน่นอน)

นอกจากนี้ วิดีโอที่มี Cameo ของผู้ใช้งาน รวมถึงฉบับร่างที่สร้างโดยผู้ใช้รายอื่นจะปรากฏให้เห็นเสมอ ทำให้เจ้าของภาพและเสียงนั้นสามารถตรวจสอบและลบ (และหากจำเป็น สามารถรายงาน) วิดีโอใดๆ ที่มี Cameo ได้อย่างง่ายดาย ผู้พัฒนา ยังใช้มาตรการป้องกันความปลอดภัยเพิ่มเติมกับวิดีโอใดๆ ที่มี Cameo และผู้ใช้งาน ยังสามารถตั้งค่ากำหนดพฤติกรรมของ Cameo ของผู้ใช้งานได้

3.มาตรการป้องกันสำหรับวัยรุ่น (Safeguards for teens) Sora มีมาตรการป้องกันที่เข้มงวดมากขึ้นสำหรับผู้ใช้ที่อายุน้อยกว่า รวมถึงการจำกัดเนื้อหาที่ไม่เหมาะสม ฟีดได้รับการออกแบบให้เหมาะสมกับวัยรุ่น โปรไฟล์ของวัยรุ่นจะไม่ถูกแนะนำให้ผู้ใช้งานที่เป็นผู้ใหญ่ได้เห็น และผู้ใหญ่ไม่สามารถเริ่มต้นส่งข้อความกับวัยรุ่นได้ การควบคุมโดยผู้ปกครองแบบใหม่ใน ChatGPT ช่วยให้ผู้ปกครองจัดการได้ว่าวัยรุ่นสามารถส่งและรับข้อความส่วนตัวได้หรือไม่ รวมถึงเลือกฟีดที่ไม่ปรับแต่งส่วนบุคคลในแอปพลิเคชั่น Sora และโดยค่าเริ่มต้น วัยรุ่นยังมีข้อจำกัดเกี่ยวกับจำนวนครั้งที่สามารถเลื่อนดูเนื้อหาใน Sora ได้อย่างต่อเนื่องอีกด้วย

4.คัดกรองเนื้อหาที่เป็นอันตราย (Filtering harmful content) Sora ใช้ระบบป้องกันหลายชั้นเพื่อรักษาความปลอดภัยของฟีดในขณะที่ยังคงเปิดโอกาสให้เกิดความคิดสร้างสรรค์ ในขั้นตอนการสร้าง ระบบจะพยายามบล็อกเนื้อหาที่ไม่ปลอดภัยก่อนที่จะถูกสร้างขึ้น รวมถึงเนื้อหาทางเพศ การโฆษณาชวนเชื่อของผู้ก่อการร้าย และการส่งเสริมการทำร้ายตัวเอง โดยตรวจสอบทั้งข้อความแจ้งเตือนและผลลัพธ์ในเฟรมวิดีโอและบันทึกเสียงหลายเฟรม

ผู้พัฒนาได้ทดสอบระบบเพื่อสำรวจความเสี่ยงใหม่ๆ และเข้มงวดนโยบายที่เกี่ยวข้องกับการสร้างภาพมากขึ้น เนื่องจาก Sora มีความสมจริงมากขึ้นและมีการเพิ่มการเคลื่อนไหวและเสียง นอกเหนือจากการสร้างภาพแล้ว ระบบอัตโนมัติจะสแกนเนื้อหาฟีดทั้งหมดเทียบกับนโยบายการใช้งานทั่วโลก และกรองเนื้อหาที่ไม่ปลอดภัยหรือไม่เหมาะสมกับวัยออก ระบบเหล่านี้ได้รับการปรับปรุงอย่างต่อเนื่องเมื่อผู้พัฒนาได้เรียนรู้เกี่ยวกับความเสี่ยงใหม่ๆ และเสริมด้วยการตรวจสอบโดยมนุษย์ที่มุ่งเน้นไปที่อันตรายที่มีผลกระทบสูงสุด

5.ระบบรักษาความปลอดภัยด้านเสียง (Audio safeguards) การเพิ่มเสียงลงใน Sora ยกระดับมาตรฐานความปลอดภัย และถึงแม้ว่าการป้องกันที่สมบูรณ์แบบนั้นทำได้ยาก แต่ผู้พัฒนายังคงลงทุนอย่างจริงจังในด้านนี้อย่างต่อเนื่อง Sora จะสแกนข้อความถอดเสียงที่สร้างขึ้นโดยอัตโนมัติเพื่อตรวจสอบการละเมิดนโยบายที่อาจเกิดขึ้น และยังบล็อกความพยายามในการสร้างเพลงที่เลียนแบบศิลปินที่ยังมีชีวิตอยู่หรือผลงานที่มีอยู่ ระบบของ Sora ได้รับการออกแบบมาเพื่อตรวจจับและหยุดการกระทำดังกล่าว และเคารพคำขอให้ลบจากผู้สร้างที่เชื่อว่าผลลัพธ์ของ Sora ละเมิดผลงาน

6.การควบคุมและการแก้ไขปัญหาของผู้ใช้ (User control and recourse) ผู้ใช้งานเลือกได้ว่าจะแชร์วิดีโอของตนเองเมื่อใดและอย่างไร และสามารถลบเนื้อหาที่เผยแพร่แล้วได้ทุกเมื่อ วิดีโอจะถูกแชร์ไปยังฟีดก็ต่อเมื่อผู้ใช้งานเลือกที่จะทำเช่นนั้นเท่านั้น ทุกวิดีโอ โปรไฟล์ และความคิดเห็นสามารถถูกรายงานได้หากมีการละเมิด โดยมีขั้นตอนการดำเนินการที่ชัดเจนเมื่อมีการละเมิดนโยบาย ผู้ใช้งานยังสามารถเลือกที่จะบล็อกบัญชีได้ทุกเมื่อ ซึ่งจะป้องกันไม่ให้ผู้อื่นเห็นโปรไฟล์หรือติดต่อผู้ใช้งานผ่านข้อความโดยตรง

– นอกจาก Sora แล้ว ยังมีเครื่องมือ AI สำหรับสร้างคลิปวิดีโอจากผู้พัฒนารายอื่นๆ อีกหรือไม่? :หากนำคำว่า “video gen ai tools” ไปค้นหาในอินเตอร์เน็ต จะพบการแนะนำเครื่องมือปัญญาประดิษฐ์แบบรู้สร้าง (Generation AI) สำหรับทำคลิปวิดีโอจำนวนมาก เช่น Veo โดย Google , Grok Imagine โดยบริษัท xAI ของ อีลอน มัสก์ มหาเศรษฐีเจ้าของ SpaceX , Tesla และแพลตฟอร์มสื่อสังคมออนไลน์อย่าง X หรืออย่าง Canva ที่หลายคนนิยมนำมาทำสไลด์นำเสนอผลงาน รวมถึง Capcut โปรแกรมตัดต่อวิดีโอยอดนิยมของยุคนี้ ก็มีฟังก์ชั่นใช้ AI สร้างคลิปวิดีโอด้วย เป็นต้น

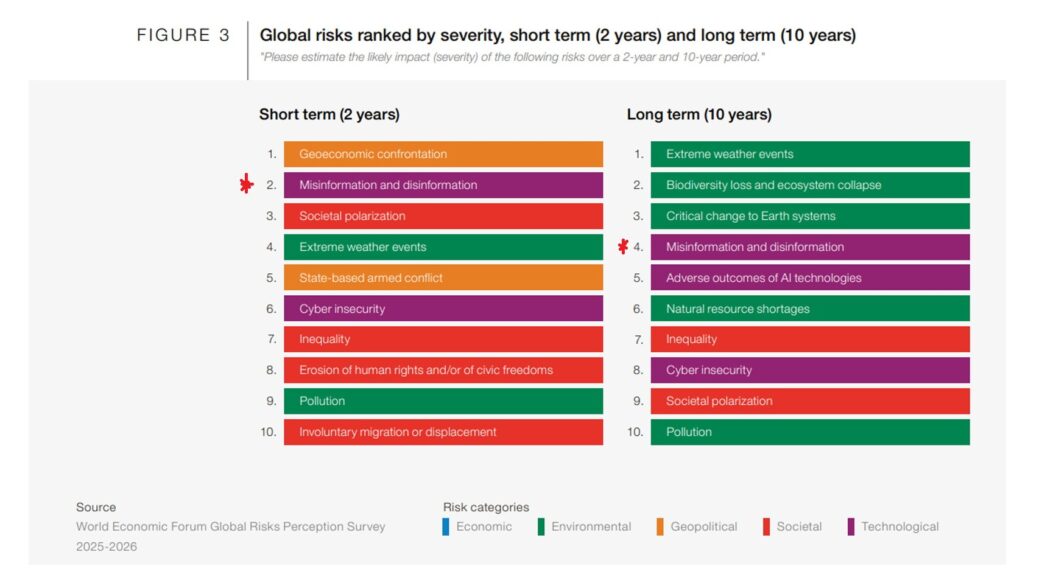

ที่มา : รายงาน Global Risks Report 2026 โดย World Economic Forum

– เครื่องมือ AI สำหรับทำคลิปวิดีโอกับความเสี่ยงข่าวลวงระบาด : แม้จะช่วยส่งเสริมความคิดสร้างสรรค์และอำนวยความสะดวกในการนำเสนอผลงาน แต่เครื่องมือเครื่องมือ AI สำหรับทำคลิปวิดีโอที่ใช้งานได้ง่าย สะดวกและเข้าถึงได้ในราคาไม่แพง กำลังกลายเป็นความกังวลในระดับโลกว่าอาจทำให้ปัญหา “ข่าวลวง – ข้อมูลบิดเบือน (Fake News – Disinformation)” ทวีความรุนแรงยิ่งขึ้น เพราะนับวันเครื่องมือเหล่านี้สามารถสร้างวิดีโอได้เนียนเราวกับเป็นเหตุการณ์ที่เกิดขึ้นจริง

รายงานข่าว Google’s AI video tool amplifies fears of an increase in misinformation โดยสำนักข่าวอัลจาซีราของกาตาร์ วันที่ 26 มิ.ย. 2568 กล่าวถึงความกังวลเกี่ยวกับ “Veo3” เครื่องมือ AI สร้างคลิปวิดีโอที่พัฒนาโดย Google ซึ่งสามารถสร้างวิดีโอความยาว 8 วินาทีจากข้อความที่กำหนด ระบบนี้เป็นหนึ่งในระบบที่ครอบคลุมที่สุดที่มีให้ใช้งานในปัจจุบันโดยไม่เสียค่าใช้จ่าย สร้างภาพและเสียงที่สมจริงมากจนผู้ชมทั่วไปแทบจะแยกไม่ออก

“เพื่อดูว่ามันทำอะไรได้บ้าง อัลจาซีราจึงสร้างวิดีโอปลอมขึ้นมาในเวลาไม่กี่นาที โดยใช้ข้อความแจ้งว่าผู้ประท้วงในนิวยอร์ก (สหรัฐอเมริกา) อ้างว่าได้รับเงินค่าจ้างให้เข้าร่วมการประท้วง ซึ่งเป็นประเด็นที่พรรครีพับลิกันมักใช้เพื่อลดทอนความชอบธรรมของการประท้วง พร้อมกับภาพที่ดูเหมือนจะแสดงให้เห็นความไม่สงบที่รุนแรง ผลลัพธ์ที่ได้แทบแยกไม่ออกจากภาพเหตุการณ์จริง

นอกจากนี้ อัลจาซีรายังสร้างวิดีโอปลอมที่แสดงภาพการโจมตีด้วยขีปนาวุธทั้งในกรุงเตหะราน(อิหร่าน) และกรุงเทลอาวีฟ (อิสราเอล) โดยใช้คำสั่ง “แสดงภาพการทิ้งระเบิดในเทลอาวีฟ” และคำสั่งที่คล้ายกันสำหรับเตหะราน Veo 3 ระบุในเว็บไซต์ของตนว่าบล็อก “คำขอและผลลัพธ์ที่เป็นอันตราย” แต่ อัลจาซีรากลับไม่มีปัญหาในการสร้างวิดีโอปลอมเหล่านี้” รายงานของอัลจาซีรา เล่าถึงการทดลองสร้างคลิปวิดีโอปลอมด้วยเครื่องมือของ Google

เบน โคลแมน (Ben Colman) ซีอีโอของบริษัทตรวจจับการใช้เทคโนโลยีปลอมภาพและเสียง(deepfake) อย่างReality Defender กล่าวกับอัลจาซีรา ว่าเมื่อเร็ว ๆ นี้ ตนได้สร้างวิดีโอให้ดูเหมือนว่ากำลังพูดอยู่ในงาน Web Summit โดยใช้เพียงภาพถ่ายภาพเดียวและเงินเพียงไม่กี่ดอลลาร์ ซึ่งพบว่าสามารถหลอกทีมงานและเพื่อนร่วมงานของตน ตลอดผู้เชี่ยวชาญด้านความปลอดภัยได้ และหากคนแบบตนยังทำแบบนี้ได้ในเวลาเพียงไม่กี่นาที อยากให้ลองนึกภาพดูว่าหากเป็นผู้ไม่หวังดีที่มีแรงจูงใจบวกกับมีเวลาและมีทรัพยากรไม่จำกัดจะทำอะไรได้บ้าง

ขณะที่ทาง Google ชี้แจงว่า Google มุ่งมั่นที่จะพัฒนา AI อย่างมีความรับผิดชอบ และมีนโยบายที่ชัดเจนเพื่อปกป้องผู้ใช้จากอันตรายและควบคุมการใช้เครื่องมือ AI ของบริษัท เนื้อหาใดๆ ที่สร้างขึ้นด้วย Google AI จะมีลายน้ำ SynthID และยังเพิ่มลายน้ำที่มองเห็นได้ในวิดีโอของ Veo ด้วย ทั้งนี้ ในปี 2567 Google เคยเผยแพร่รายงานที่ยอมรับถึงภัยคุกคามจากเครื่องมือปัญญาประดิษฐ์แบบรู้สร้าง (Generative AI) ว่าจะทำให้ปัญหาข้อมูลเท็จรุนแรงขึ้น เนื่องจากวิธีการเหล่านี้สามารถสร้างเนื้อหาเสียงและภาพที่สมจริงสูง รวมถึงข้อความที่เป็นธรรมชาติและลื่นไหล ในระดับที่ไม่เคยเป็นไปได้มาก่อนหากปราศจากแรงงานคนจำนวนมหาศาล

รายงานข่าว Sora gives deepfakes ‘a publicist and a distribution deal.’ It could change the internet โดยสำนักข่าว NPR สหรัฐอเมริกา เมื่อวันที่ 10 ต.ค. 2568 อ้างคำให้สัมภาษณ์ของ เดซี โซเดอร์เบิร์ก – ริฟกิน (Daisy Soderberg-Rivkin) อดีตผู้จัดการฝ่ายความไว้วางใจและความปลอดภัยของแพลตฟอร์มสื่อสังคมออนไลน์อย่าง TikTok ที่กล่าวว่า Sora น่าจะเป็นจุดเปลี่ยนสำคัญในประวัติศาสตร์ของอินเตอร์เน็ต เป็นช่วงเวลาที่ deepfake เปลี่ยนจากปรากฏการณ์ที่เกิดขึ้นเป็นครั้งคราวกลายเป็นเรื่องปกติ ซึ่งอาจทำให้ผู้คนห่างเหินจากสื่อสังคมออนไลน์มากขึ้น หรืออย่างน้อยก็ทำลายความเชื่อมั่นในความน่าเชื่อถือของสิ่งที่ผู้คนรับชมทางออนไลน์

“ฉันไม่ได้กังวลเกี่ยวกับสถานการณ์เลวร้ายที่สุดที่วิดีโอปลอมจะส่งผลต่อการเลือกตั้งมากนัก แต่กังวลเกี่ยวกับการเซาะกร่อนบ่อนทำลายความเชื่อมั่นในระดับพื้นฐานมากกว่า ในโลกที่ทุกอย่างสามารถเป็นของปลอมได้ และของปลอมเหล่านั้นดูและรู้สึกเหมือนจริง ผู้คนจะหยุดเชื่อทุกอย่าง” โซเดอร์เบิร์ก – ริฟกิน กล่าว

– การแข่งขันทางธุรกิจกำลังส่งผลกระทบต่อสังคม? : รายงานข่าวของ NPR ยังอ้างว่าได้พุดคุยกับอดีตพนักงานของ OpenAI ซึ่งขอไม่เปิดเผยชื่อต่อสาธารณะเกี่ยวกับเครื่องมือ Sora โดยรายแรกกล่าวว่า การเปิดตัว Sora เป็นการบอกให้โลกรู้ว่าอนาคตจะเป็นอย่างไร วิดีโอ AI อาจเป็นพรมแดนสุดท้ายของสื่อสังคมออนไลน์ที่ยังไม่ถูกพิชิต และ OpenAI ต้องการเป็นเจ้าของมัน แต่ในขณะที่ซิลิคอนวัลเลย์แข่งขันกันอย่างดุเดือด บริษัทต่างๆ จะบิดเบือนกฎเกณฑ์เพื่อรักษาความสามารถในการแข่งขัน และนั่นอาจเป็นผลเสียต่อสังคม

อดีตพนักงานอีกราย ให้ความเห็นว่า การปล่อยแพลตฟอร์ม AI deepfake ออกมานั้นเป็นการตัดสินใจทางธุรกิจที่ถูกต้อง แม้ว่ามันจะส่งผลให้ความรู้สึกร่วมกันเกี่ยวกับความเป็นจริงของทุกคนพังทลายลงก็ตาม ดังนั้นเราจึงมาถึงจุดที่บอกไม่ได้แล้วว่าอะไรจริง – ไม่จริงในโลกออนไลน์ ซึ่งทั้ง OpenAI และบริษัทเทคโนโลยีอื่นๆ จะต้องหาทางแก้ไขปัญหานี้ แต่นั่นไม่ใช่ข้ออ้างที่จะไม่พยายามครองตลาดนี้ เพราะไม่มีใครหยุดความก้าวหน้าได้ ถึงแม้ OpenAI ไม่ปล่อย Sora ออกมา ผู้พัฒนาเจ้าอื่นก็คงทำอยู่ดี อย่างไรก็ตาม เมื่อสอบถามไปทาง OpenAI ก็ได้รับการปฏิเสธที่จะให้ความเห็นใดๆ

รายงานของ NPR ยังกล่าวถึง Meta บริษัทที่เป็นเจ้าของแพลตฟอร์มสื่อสังคมออนไลน์อย่าง Facebook และ Instagram ก็เคลื่อนไหวในสนามนี้เช่นกัน ด้วยการเปิดตัว Vibes แพลตฟอร์มที่ผู้คนสามารถสร้างและแบ่งปัน deepfake สั้นๆ ที่สร้างโดย AI ได้ ขณะที่ในเดือน ก.ค. 2568 Google ได้เปิดตัวเครื่องมือสร้างวิดีโอด้วย AI อย่าง Veo3 แต่กว่าที่ AI ส่วนบุคคลจะได้รับความนิยมอย่างแท้จริง ก็ต้องรอจนกระทั่ง OpenAI เปิดตัวแอป Sora นั่นเอง

ที่มา : https://x.com/elonmusk/status/2006868990287810750

– เมื่อของปลอมจาก AI ถูกใช้ล่วงละเมิดผู้อื่น :กรณีอื้อฉาวที่สุดของการสร้างรูปภาพหรือคลิปวิดีโอด้วย AI เกิดขึ้นกับ Grok ถึงขั้นที่ทางการของบางประเทศ เช่น อินโดนีเซีย มาเลเซีย ต้องสั่งแบน เนื่องจากมีการนำไปใช้สร้างภาพลามกอนาจารของเด็กและผู้หญิงโดยไม่ได้รับความยินยอม โดยสำนักข่าว BBC ของอังกฤษ รายงานเมื่อวันที่ 12 ม.ค. 2569 อ้างการเปิดเผยของคณะกรรมการการสื่อสารและมัลติมีเดียของมาเลเซีย เมื่อวันที่ 11 ม.ค. 2569 ว่า ได้ออกหนังสือแจ้งเตือนไปยัง X เมื่อต้นปีเพื่อขอให้ดำเนินการที่เข้มงวดมากขึ้น หลังจากพบว่ามีการใช้ในทางที่ผิดซ้ำแล้วซ้ำเล่า เพื่อสร้างเนื้อหาที่เป็นอันตราย

“แต่ในการตอบสนอง X ล้มเหลวในการกล่าวถึงความเสี่ยงที่แฝงอยู่ในการออกแบบแพลตฟอร์ม และมุ่งเน้นไปที่กระบวนการรายงานสำหรับผู้ใช้เป็นหลัก ดังนั้น Grok จะถูกบล็อกจนกว่าจะมีการใช้มาตรการป้องกันที่มีประสิทธิภาพ และเรียกร้องให้ประชาชนรายงานเนื้อหาออนไลน์ที่เป็นอันตราย”หน่วยงานกำกับดูแลสื่อของมาเลเซีย กล่าว

เช่นเดียวกับ เมตยา ฮาฟิด (Meutya Hafid) รัฐมนตรีว่าการกระทรวงการสื่อสารและกิจการดิจิทัลของอินโดนีเซีย โพสต์ข้อความผ่านอินสตาแกรม ระบุว่า การใช้ Grok ในการผลิตเนื้อหาที่แสดงออกทางเพศอย่างโจ่งแจ้งเป็นการละเมิดสิทธิมนุษยชน ศักดิ์ศรี และความปลอดภัยทางออนไลน์ซึ่งกระทรวงฯ ได้เรียกร้องให้บริษัทของมัสก์ชี้แจงเกี่ยวกับการใช้งาน Grok ด้วย

ขณะที่ในอังกฤษ นายกรัฐมนตรี เคียร์ สตาร์เมอร์ (Keir Starmer) ประณามการใช้ Grok สร้างภาพลามกอนาจารว่าเป็นเรื่องน่าละอายและน่ารังเกียจ เช่นเดียวกับรัฐมนตรีว่าการกระทรวงวิทยาศาสตร์ นวัตกรรมและเทคโนโลยี ลิซ เคนดัลล์ (Liz Kendall) เปิดเผยว่า ตนจะสนับสนุน Ofcomหน่วยงานกำกับดูแลด้านโทรคมนาคมของประเทศ หาก Ofcom ตัดสินใจปิดกั้นการเข้าถึง Grok ในอังกฤษ ด้วยเหตุแห่งการฝ่าฝืนกฎหมายความปลอดภัยทางออนไลน์

ในเวลาต่อมา วันที่ 15 ม.ค. 2569 สำนักข่าว CNN สหรัฐอเมริกา รายงานว่า เมื่อวันที่ 14 ม.ค. 2569 ทาง X ได้ออกมายืนยันว่า ได้ปรับปรุงระบบของ Grok ไม่ให้สามารถใช้สร้างภาพโป๊เปลือยวาบหวิวจากบุคคลที่มีอยู่จริงได้อีกต่อไป และมีผลบังคับใช้กับผู้ใช้งานทุกคนทั้งที่จ่ายและไม่จ่ายเงินค่าสมัครใช้งาน เช่นเดียวกับ อีลอน มัสก์ ได้ออกมาย้ำว่า Grok จะปฏิเสธที่จะผลิตสิ่งใดๆ ที่ผิดกฎหมาย เนื่องจากหลักการทำงานของ Grok คือการปฏิบัติตามกฎหมายของประเทศหรือรัฐใดๆ ก็ตาม

อย่างไรก็ตาม นักวิจัยจาก AI Forensics องค์กรไม่แสวงหาผลกำไรในยุโรปที่ตรวจสอบอัลกอริทึม กล่าวว่าพวกเขาพบ “ความไม่สอดคล้องกันในการจัดการกับการสร้างเนื้อหาลามกอนาจาร” ระหว่างการโต้ตอบสาธารณะกับ Grok บน X และการแชทส่วนตัวบน Grok.com รวมถึงตั้งข้อสังเกตว่า แม้จะพบเห็นภาพเปลือยในลักษณะเต็มตัวได้ยาก แต่ปัญหาที่ใหญ่ที่สุดคือ Grok ปฏิบัติตามคำขอของผู้ใช้ในการแก้ไขภาพของเด็กและเปลี่ยนเสื้อผ้าให้เป็นแบบเปิดเผย เช่น ชุดว่ายน้ำ ชุดชั้นใน รวมถึงอยู่ในท่าทางที่ยั่วยุทางเพศ

– คำเตือนจากแพลตฟอร์มถูกลบออกได้ – การปิดกั้นของรัฐก็ป้องกันไม่อยู่ : นสพ.The Guardian ของอังกฤษ รายงานเมื่อวันที่ 18 ม.ค. 2569 ว่า แม้รัฐบาลอินโดนีเซียและมาเลเซียจะสั่งปิดกั้นการเข้าถึง Grok แต่ในความเป็นจริงยังพบการเข้าถึงได้ผ่านการใช้เครื่องมือ VPN (Virtual Private Network) หรือเครื่องมือ DNS เพื่อปกปิดตัวตนหรือเปลี่ยนแปลงที่อยู่ของผู้ใช้งาน (IP Address) เมื่อใช้งานอินเตอร์เน็ต

อีกทั้งยังพบว่า แม้การใช้ Grok ผ่านบัญชีแพลตฟอร์ม X จะไม่สามารถสร้างภาพโป๊เปลือยของบุคคลจริงได้แล้ว แต่ก็ยังพบวิธีหลีกเลี่ยงข้อจำกัดด้วยการใช้ Grok เวอร์ชัน Stand Alone เพื่อสร้างคลิปวิดีโอสั้นที่แสดงการลบเสื้อผ้าออกจากภาพของบุคคลจริง แล้วนำมาโพสต์ลงบนแพลตฟอร์มสาธารณะของ X ซึ่งผู้ใช้ทั่วโลกสามารถรับชมได้ภายในไม่กี่วินาที

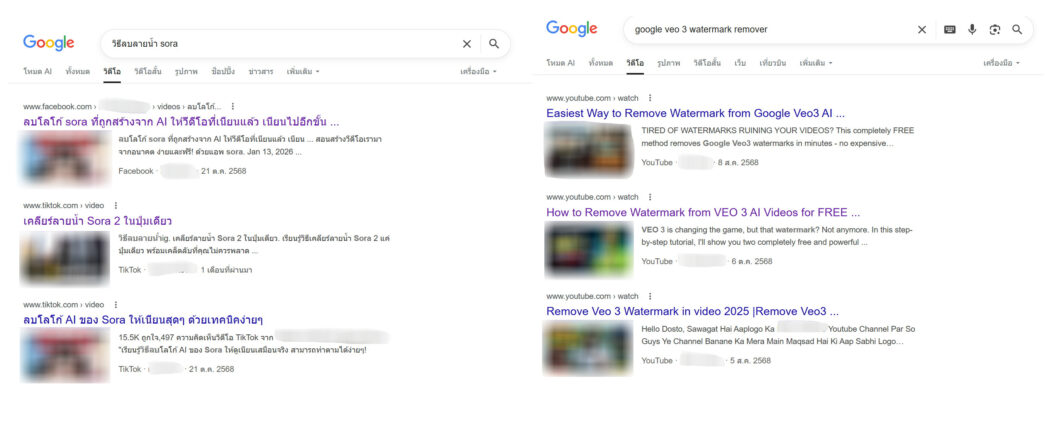

เช่นเดียวกับรายงานข่าวโดย นสพ. The Seattle Times สื่อท้องถิ่นเมืองซีแอทเทิล รัฐวอชิงตันของสหรัฐฯ วันที่ 2 พ.ย. 2568 ระบุว่า แม้ผู้พัฒนา Sora จะตั้งค่าระบบไว้ว่าคลิปวิดีโอที่ใช้เครื่องมือ AI นี้สร้างขึ้นจะปรากฏลายน้ำชัดเจน แต่ในความเป็นจริงผู้ใช้งานสามารถหาวิธีลบลายน้ำออกได้ และข่าวร้ายคือ “คำแนะนำใดๆ เกี่ยวกับวิธีการสังเกตวิดีโอที่สร้างโดย AI นั้นคงใช้ได้ไม่นาน เพราะเทคโนโลยีกำลังพัฒนาอย่างรวดเร็ว” โดย ฮานี ฟาริด (Hany Farid) ศาสตราจารย์ด้านวิทยาการคอมพิวเตอร์แห่งมหาวิทยาลัยแคลิฟอร์เนีย เบิร์กลีย์ กล่าวว่า พื้นที่สื่อสังคมออนไลน์กลายเป็นแหล่งรวมของปลอมโดยสิ้นเชิง และวิธีหนึ่งที่จะหลีกเลี่ยงได้แน่นอนคือเลิกใช้มัน!!!

-/-/-/-/-/-/-/-/-/-/-

อ้างอิง

https://www.prachachat.net/general/news-1952032 (สรุปเหตุเครนถล่มทับรถไฟสีคิ้ว เสียชีวิต 30 ราย เยียวยา 1.69 ล้านบาท : ประชาชาติ 17 ม.ค. 2569)

https://openai.com/index/sora-is-here/ (Sora is here : OpenAI 9 ธ.ค. 2567)

https://www.reuters.com/technology/artificial-intelligence/openai-releases-text-to-video-model-sora-chatgpt-plus-pro-users-2024-12-09/ (OpenAI releases text-to-video model Sora for ChatGPT Plus and Pro users : รอยเตอร์ 9 ธ.ค. 2567)

https://openai.com/th-TH/index/sora-2/ (Sora 2 is here : OpenAI 30 ก.ย. 2568)

https://openai.com/index/launching-sora-responsibly/ (Launching Sora responsibly : OpenAI 30 ก.ย. 2568)

https://www.aljazeera.com/economy/2025/6/26/googles-ai-video-tool-amplifies-fears-of-an-increase-in-misinformation (Google’s AI video tool amplifies fears of an increase in misinformation : 26 มิ.ย. 2568)

https://www.npr.org/2025/10/10/nx-s1-5567162/sora-ai-openai-deepfake (Sora gives deepfakes ‘a publicist and a distribution deal.’ It could change the internet : NPR 10 ต.ค. 2568)

https://www.bbc.com/news/articles/cg7y10xm4x2o (Malaysia and Indonesia block Musk’s Grok over explicit deepfakes : BBC 12 ม.ค. 2569)

https://edition.cnn.com/2026/01/14/tech/grok-elon-musk-image-generation (Elon Musk’s Grok can no longer undress images of real people on X : CNN 14 ม.ค. 2569)

https://www.theguardian.com/technology/2026/jan/18/grok-x-ai-tool-still-accessible-malaysia-despite-ban-vpns (‘Still here!’: X’s Grok AI tool accessible in Malaysia and Indonesia despite ban : The Guardian 18 ม.ค. 2569)

https://www.nia.go.th/cyber/cyberpage/299/ (ข้อแนะนำการใช้งาน VPN เบื้องต้นเพื่อเพิ่มความที่ปลอดภัยในการใช้งานอินเทอร์เน็ต : สำนักข่าวกรองแห่งชาติ)

https://www.seattletimes.com/business/ai-video-generators-are-now-so-good-you-can-no-longer-trust-your-eyes/ (AI video generators are now so good you can no longer trust your eyes : The Seattle Times 2 พ.ย. 2568)

https://reports.weforum.org/docs/WEF_Global_Risks_Report_2026.pdf (The Global Risks Report 2026 : WEF 14 ม.ค. 2569)