เสวนานักคิดดิจิทัลครั้งที่ 26 เปิดมุมมองผู้เชี่ยวชาญด้าน AI จะรับมือและใช้ประโยชน์อย่างสร้างสรรค์

17 ม.ค. 2567 ภาคีโคแฟค (ประเทศไทย) ร่วมกับ สำนักงานกองทุนสนับสนุนการสร้างเสริมสุขภาพ (สสส.) Centre for Humanitarian Dialogue (HD) สถาบันเชนจ์ฟิวชั่น มูลนิธิฟรีดริช เนามัน (ประเทศไทย) สภาการสื่อมวลชนแห่งชาติ สภาองค์กรของผู้บริโภค สถานีโทรทัศน์ไทยพีบีเอส Tellscore และ Creative Citizen จัดงาน Digital Thinkers Forum # เวทีนักคิดดิจิทัลครั้งที่ 26 “เราจะใช้เอไออย่างไรให้สร้างสรรค์และปลอดภัย” ณ Siam Paragon NEXT TECH x SCBX ชั้น 4 สยามพารากอน พร้อมถ่ายทอดสดผ่านช่องยูทูป “Thai PBS” และเพจเฟซบุ๊ก “Cofact โคแฟค” สภาการสื่อมวลชนแห่งชาติ และสภาองค์กรของผู้บริโภค

นางเบญจมาภรณ์ ลิมปิษเฐียร ผู้ช่วยผู้จัดการสำนักงานกองทุนสนับสนุนการสร้างเสริมสุขภาพ (สสส.) กล่าวเปิดงาน ฉายภาพการทำงานของ สสส. ที่ประเด็นเกี่ยวกับสื่อเป็นอีกหนึ่งเรื่องใกล้ตัว โดยเฉพาะเทคโนโลยีปัญญาประดิษฐ์ (เอไอ-AI) ที่เป็นได้ทั้งบวกและลบ ซึ่ง สสส. มีแผนงานที่ทำงานด้านระบบสื่อและวิถีสุขภาวะทางปัญญา

“ พื้นฐานของ AI คือเทคโนโลยีที่ถูกออกแบบให้มีระบบทำงานเหมือนกับการทำงานของสมองมนุษย์ ปัจจุบันซอฟต์แวร์หลาย ๆ ตัวที่ขับเคลื่อนด้วยระบบ AI และพยายามทำให้มีความสามารถในการตอบโต้เหมือนกับมนุษย์ด้วยกันให้ได้มากที่สุด ซึ่งส่งทั้งในทางบวกและทางลบ ในเวทีเสวนาวันนี้เราจะร่วมกันมองว่ามีหนทางที่ช่วยกันพัฒนานโยบายสาธารณะ เพื่อหาทางป้องกันและพัฒนาให้เกิดการสื่อสาร พูดคุยกัน รู้จักและใช้ AIให้เป็นไปในทางที่สร้างสรรค์มากที่สุด” ผู้ช่วยผู้จัดการ สสส. กล่าว

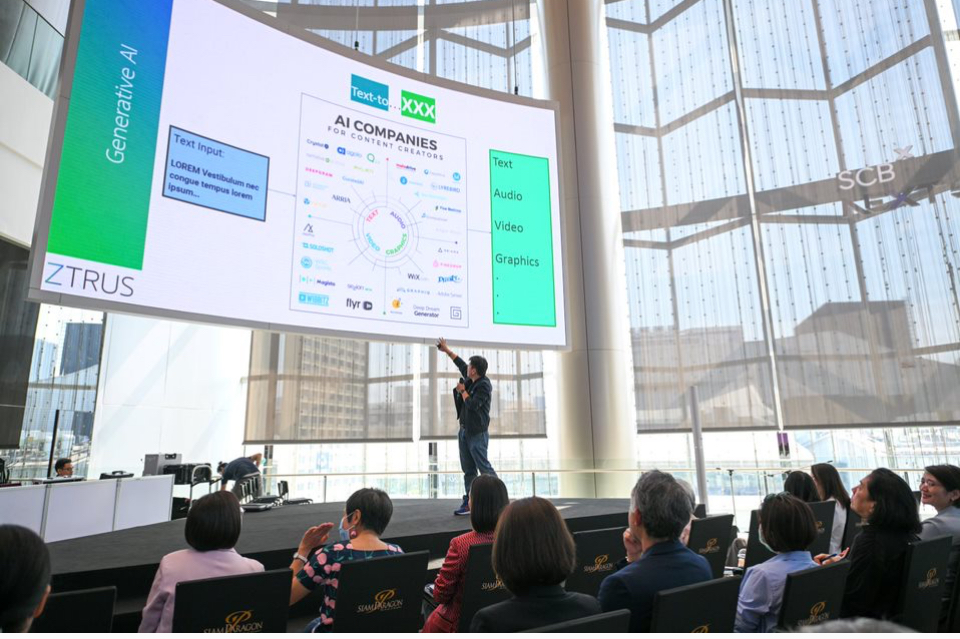

จากนั้นเป็นการปาฐกถาในหัวข้อ “เราจะใช้ AI อย่างไรให้สร้างสรรค์และปลอดภัย” โดย พณชิต กิตติปัญญางาม CEO, ZTRUS กรรมการผู้ทรงคุณวุติ สถาบันเพื่อการยุติธรรมประเทศไทย เริ่มต้นด้วย “6 คำเตือนหรือข้อควรระวังเกี่ยวกับ AI” ได้แก่ 1.เลือกใช้อย่างระมัดระวัง 2.อย่าใส่ข้อมูลส่วนตัวเข้าไป 3.อย่าใช้เนื้อหาลอกเลียนแบบ (Plagiarized) 4.อย่าให้ระบบสนทนา (Chat) บันทึกข้อมูลที่เราพิมพ์ไว้ 5.ระวังทุกกิจกรรมที่อันตราย และ 6.อย่าเชื่อว่า AI จะแม่นยำ (Accuracy) ซึ่งทั้งหมดนี้ “พูดง่ายแต่ทำยาก” เพราะในความเป็นจริงแต่ละคนแชร์ข้อมูลในสื่อสังคมออนไลน์กันมาก อีกทั้ง “ปริมาณข้อมูลมหาศาลที่พุ่งเข้าใส่ในทุกวินาทีจนยากที่มนุษย์จะตั้งสติรับมือได้ทัน” โดยเฉพาะเมื่อมีการใช้ “บอท (Bot)” หรือโปรแกรมอัตโนมัติช่วยสร้างหรือเผยแพร่ข้อมูล ขณะที่เทคโนโลยีปัญญาประดิษฐ์ “เหตุที่ AI ดูฉลาด จริงๆ แล้วมาจากการเดาบนข้อมูลสถิติ” เมื่อใครคนหนึ่งจะพัฒนา AI ก็จะใช้หลักคิดว่า เมื่อมีการป้อนข้อมูลแบบหนึ่งเข้าไป สิ่งที่ AI ควรจะตอบโต้กลับมาคืออะไร และพยายามสะสมชุดคำตอบในคำถามเดียวกันให้มากที่สุด จากนั้นเลือกคำตอบที่คิดว่ามนุษย์อยากเห็นที่สุด เพราะหากเป็นคำตอบที่ไม่ถูกใจ มนุษย์ก็จะมองว่า AI ไม่ฉลาด

“ในการสร้าง AI นั้นเป็นศาสตร์ของของปลอม (Artificial Science) เรารู้ว่ากระเป๋าใบนี้เป็นแบรนด์เนมปลอมเพราะเรารู้ว่าของจริงหน้าตาเป็นอย่างไร ฉะนั้นก่อนเราจะรู้ของปลอมเราต้องเข้าใจของจริงก่อน เราถึงจะรู้ได้ว่าเราจะบริหารจัดการของปลอมนี้อย่างไร หลายคนอาจคิดว่า AI จะต้องคุ้มครองสร้างสรรค์ให้ปลอดภัย มันเป็นไปไม่ได้ถ้าเรายังไม่เคยทำความเข้าใจการรับรู้ของจริงในเรื่องต่างๆ ของมนุษย์อย่างจริงจัง” พณชิต กล่าว

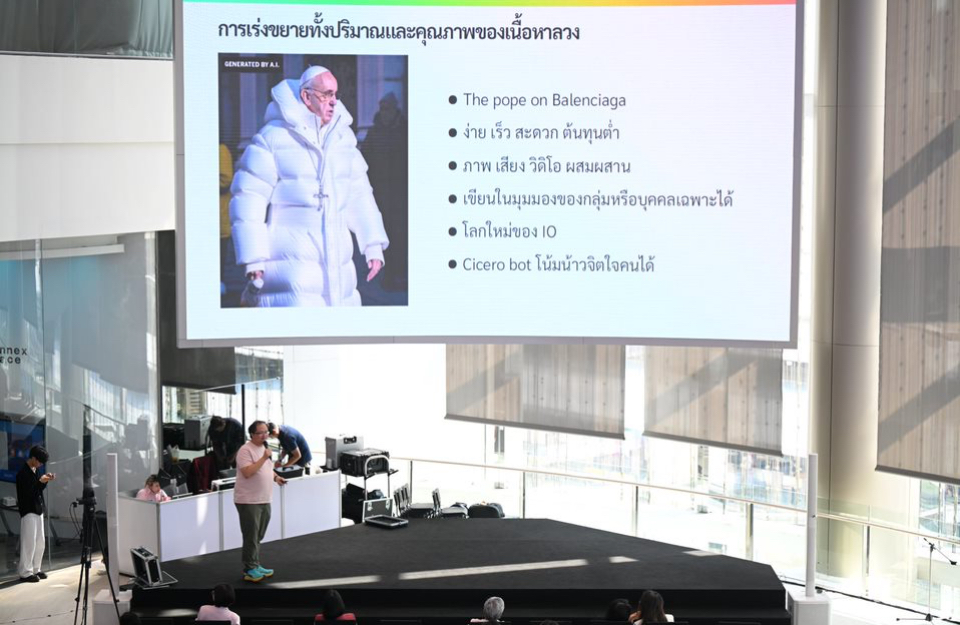

ต่อมาเป็นการนำเสนองานวิจัยโคแฟค เรื่อง “AI กับข้อมูลข่าวสาร” โดย สุนิตย์ เชรษฐา ผู้อำนวยการสถาบัน ChangeFusion รวบรวมหัวข้อ “ความเสี่ยง” ที่มีการพูดคุยกันเกี่ยวกับ “เนื้อหาที่ปัญญาประดิษฐ์สร้างขึ้น (Generative AI)” ไล่ตั้งแต่ 1.การเร่งขยายทั้งปริมาณและคุณภาพของเนื้อหาลวง ไม่ว่าภาพ เสียงหรือสื่อผสม ที่ทำได้เหมือนของจริงและมีต้นทุนต่ำ เช่น มีการปล่อยภาพสมเด็จพระสันตะปาปาฟรานซิส (Pope Francis) สวมใส่เสื้อผ้าแบรนด์ดังอย่าง บาเลนเซียกา (Balenciaga) ถูกแชร์อย่างกว้างขวางในสื่อสังคมออนไลน์ ท่ามกลางเสียงวิพากษ์วิจารณ์ว่าเป็นผู้นำศาสนาแต่ไม่เป็นแบบอย่างที่ดีด้านความสมถะ กระทั่งได้ทราบภายหลังว่าเป็นภาพที่แชร์กันนั้น AI ทำขึ้นไม่ใช่ภาพจริงแต่อย่างใด หรือ AI สามารถเขียนบทความด้วยสำนวนภาษาที่เหมือนกับนักเขียนตัวจริงคนนั้นได้ หากบทความหรือหนังสือของนักเขียนเป้าหมายถูกนำไปใส่ในฐานข้อมูลให้ AI เรียนรู้

AI ยังเขียนเนื้อหาในมุมมองของผู้มีความคิดแบบใดก็ได้ ไม่ว่าจะเป็นมุมของอาชญากร กลุ่มที่มีความคิดสุดโต่ง หรือมีแนวคิดแปลกๆ กลายเป็น“สวรรค์ของนักทำปฏิบัติการข้อมูลข่าวสาร (ไอโอ –IO)” ไม่ว่าฝ่ายรัฐ เอกชน ฯลฯ ที่สำคัญยัง “โน้มน้าวให้คนเชื่อได้เพราะไม่รู้ว่ากำลังคุยกับโปรแกรม” ซึ่งเคยมีการทดลองแล้วพบมนุษย์ไม่รู้ว่าคู่สนทนาเป็นบอทก็มี

2.ความน่าเชื่อถือของสื่อหรือข้อมูลต่างๆ ในสังคมจะลดลง เพราะคนเริ่มสับสนว่าอะไรจริง-ไม่จริง เพราะแม้แต่ผู้เชี่ยวชาญบางครั้งก็แยกไม่ออก ซึ่งเมื่อถึงสถานการณ์ที่จำเป็นต้องทำให้เชื่อข้อมูลที่ถูกต้อง เช่น โควิด-19 กับการฉีดวัคซีน ข้อมูลด้านสุขภาพหรือการเมือง ก็ไม่มีใครเชื่อ

3.ควบคุมผลลบที่เกิดขึ้นรวดเร็วได้ยาก เคยมีกรณีสื่อในต่างประเทศแชร์ภาพระเบิดใกล้อาคารกระทรวงกลาโหมสหรัฐอเมริกา (Pentagon) โดยไม่ได้แจ้งรายละเอียดที่มาของภาพ ผลคือทำให้ดัชนีตลาดหุ้นสหรัฐฯ ตกไป 0.26% ในเวลาอันสั้น

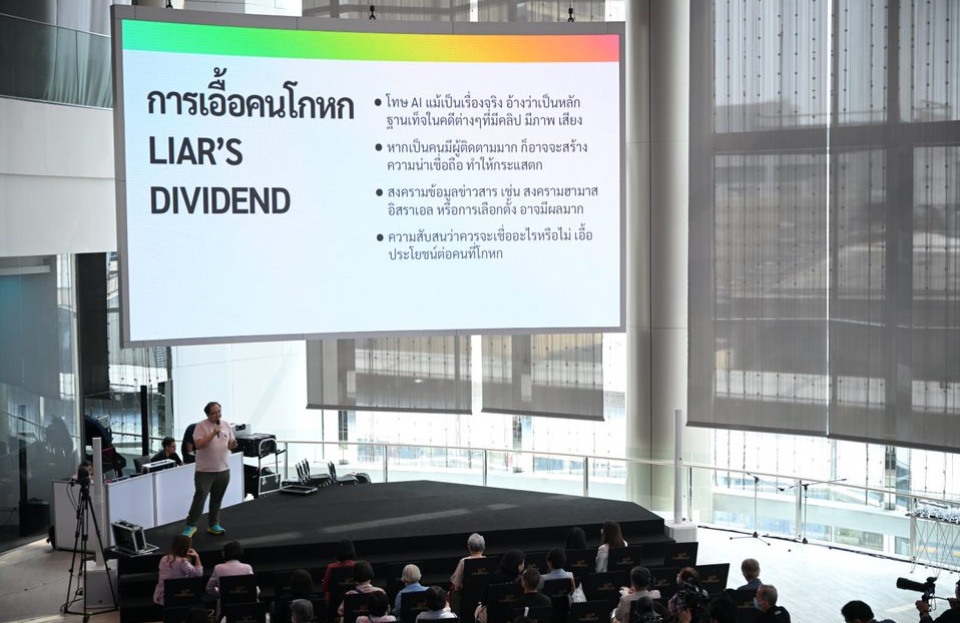

4.เอื้อประโยชน์ให้คนโกหก เช่น บุคคลที่มีชื่อเสียง มีคลิปวีดีโอหรือภาพถูกเผยแพร่ออกมา บุคคลนั้นอ้างว่านั่นคือคลิปหรือภาพที่ AI สร้างขึ้น ท้ายที่สุดเรื่องอาจจะตกไปโดยไม่มีการตรวจสอบก็ได้ เพราะคนรู้ว่า AI สร้างเนื้อหาทำนองนี้ได้ แล้วก็ไม่รู้จะแยกแยะอย่างไรว่าเรื่องใดจริง-ไม่จริง

5.ตอกย้ำ “ตัวกรองฟองสบู่ (Filter Bubble)” ขยายความเชื่อผิดๆ เคยมีการทดลองให้โปรแกรม AI ชื่อดังอย่าง Chat GPT ผลิตเนื้อหาอ้างเป็นบุคคลต่างๆ บอกว่าประเทศออสเครเลียไม่มีปัญหาเรื่องโลกร้อน และที่นี่ก็เจอไฟป่าเป็นประจำอยู่แล้ว ซึ่งเนื้อหาเหล่านี้หากปล่อยเข้าไปในกลุ่มที่มีความคิดไม่เชื่อเรื่องโลกร้อนอยู่แล้ว จะยิ่งตอกย้ำให้ไม่เชื่อมากยิ่งขึ้น

6.เป็นเครื่องมือของมิจฉาชีพ เทคโนโลยีที่เรียกว่า “ดีฟเฟค (Deepfake)” ใช้ AI ปลอมได้ทั้งภาพและเสียง มีกรณีในสหรัฐอเมริกา แม่ได้รับโทรทัพท์จากคนร้ายอ้างว่าจับลูกสาวไว้เป็นตัวประกันเพื่อเรียกค่าไถ่ โดยได้ยินเสียงลูกสาวจากปลายสายอย่างชัดเจน

7.กระทบต่อการเมืองและเสรีภาพตัวอย่างจากสหรัฐอเมริกา ปลายปี 2566 มีการรณรงค์หาเสียง “BEAT BIDEN” จากพรรครีพับลิกัน ใช้ AI ผลิตเนื้อหาโดยตั้งโจทย์ว่า หากการเลือกตั้งประธานาธิบดีครั้งหน้า โจ ไบเดน จากพรรคเดโมแครต ชนะอีกสมัย จะเกิดอะไรขึ้น ผลคือ AI สร้างภาพที่รถถังวิ่งเกลื่อนในเมือง อาชญากรรมเพิ่มสูงขึ้น ฯลฯ โดยเขียนกำกับไว้ตัวเล็กๆ ตรงหัวมุมว่าเป็นภาพที่ใช้ AI สร้างขึ้น

ในทางกลับกัน บางประเทศเริ่มปิดกั้นการพัฒนา Generative AI หรือหันไปพัฒนาระบบของตนเอง เช่น ประเทศจีน สั่งห้ามบริษัทเทคโนโลยีของจีนไปเชื่อมต่อระบบกับ Chat GPT ขณะที่ยักษ์ใหญ่ไอทีของสหรัฐอเมริกาอย่าง แอปเปิล ต้องลบแอปพลิเคชั่นที่เกี่ยวข้องออกจาก Store ที่ให้บริการในจีน แต่จีนก็สร้าง ERNIE ของไปตู้ (Baidu) ขึ้นมา หรือที่ประเทศเวียดนาม รัฐบาลก็ออกมาเตือน

ทั้งนี้ หลายประเทศเริ่มออกแนวทางกำกับดูแล AI เช่น สหรัฐอเมริกา มีคำสั่งประธานาธิบดีในปี 2566 อาทิ การทดสอบ AI ที่มีความเสี่ยงต่อความมั่นคงหรือสุขภาพ ต้องรายงานผลการทดสอบให้รัฐบาล ต้องติดลายน้ำหรือฉลาก ให้ประชาชนทราบว่าเป็นเนื้อหาที่ AI สร้างขึ้น , สหภาพยุโรป มี EU Code of Practice กลไกกำกับดูแลตนเองของผู้พัฒนา และมีการติดตามผลการปฏิบัติเป็นระยะๆ มีการออกกฎหมาย EU AI Act ที่ให้เวลาผู้เกี่ยวข้องเตรียมตัว 2 ปี หลังจากนั้นผู้กระทำผิดจะถูกลงโทษปรับตั้งแต่ 1.5-7% ของยอดขายทั่วโลกของบริการนั้นๆ

อังกฤษ ตั้งสถาบันความปลอดภัย AI ของตนเอง และพยายามเชื่อมประเทศต่างๆ ในการกำกับดูแล AI โดยจัดประชุมเมื่อเดือนพฤศจิกายน 2566 มี 27 ชาติเข้าร่วม รวมทั้งจีน ญี่ปุ่น เกาหลีใต้ ฟิลิปปินส์ มีการลงนามคำประกาศ Bletchley มีเนื้อหายอมรับถึงความเสี่ยงของ AI ในมิติต่างๆ ทั้งโดยตั้งใจและไม่ตั้งใจ และความร่วมมือ ขณะที่ “ประเทศไทย” ยังมี “ความท้าทาย” หลายประการตั้งแต่การสร้างความรู้เท่าทัน AI ให้กับประชาชน การส่งเสริมให้เกิดการประเมินและจัดการความเสี่ยงใน AI ที่เป็นภาษาไทย แนวทางการทดสอบ , การระมัดระวังอคติต่างๆ ในชุดข้อมูล เป็นต้น

“ขณะนี้กฎหมายที่เกี่ยวข้องกับ AI กำลังมีขึ้นทั่วโลก แต่สิ่งที่เรายังขาดมาก คือการวิจัยที่เป็นข้อเสนอเชิงนโยบายเกี่ยวกับเรื่องนี้ เพื่อที่จะนำมาเป็นข้อมูลนำเข้าในการปกป้องและคุ้มครองประชาชน อย่างในสหภาพยุโรปมีการวิจัยตลอดเวลาเพื่อบอกว่ากฎหมายต้องปรับอย่างไร จึงจะรับมือกับ AI ได้ รวมทั้งสร้างความร่วมมือกับทุกภาคส่วน เพื่อร่วมกันตรวจสอบว่าสิ่งไหนจริง หรือปลอม เหมือนกับการทำงานของโคแฟคที่ชวนทุกฝ่ายร่วมกันหาความจริงร่วม” สุนิตย์กล่าว

นอกจากนี้ในวงเสวนา “ความจริง ความลวงในยุคเอไอ สื่อ/พลเมืองควรรับมืออย่างไร” โดยมี สุภิญญา กลางณรงค์ ผู้ร่วมก่อตั้ง โคแฟค (ประเทศไทย) เป็นผู้ดำเนินรายการ

รณพงศ์ คำนวณทิพย์ กรรมการผู้จัดการ มายด์ เอไอ ภูมิภาคเอเชียตะวันออกเฉียงใต้ กล่าวว่า ในฐานะที่เป็นทีมพัฒนา AI รู้สึกเหมือน AI ตกเป็นจำเลยสังคม เช่น ถูกนำไปใช้เป็นเครื่องมือหลอกลวง แต่บางอย่างก็ไม่เกี่ยวกับ AI อย่างแก๊งคอลเซ็นเตอร์โทรศัพท์ไปหลอกเหยื่อแบบไม่ใช้ AI ก็มี ทั้งๆที่ AI มีหลายองค์กรหันมาใช้ AI แล้วช่วยลดต้นทุนและย่นระยะเวลาการทำงานได้ ดังนั้นสิ่งที่ตนและเพื่อนๆ ในชุมชนผู้พัฒนา AI คือ “เราต้องเข้าใจและใช้เป็น” อย่าไปกลัวเทคโนโลยี

“จริงๆ แล้ว AI มันก็คือเทคโนโลยีอย่างหนึ่ง เปรียบเสมือนยุคที่เราสร้างมีดขึ้นมาจากหินหรือจากโลหะ มีมีดเล่มหนึ่งผมถามว่ามันดีหรือไม่ดี มันมีประโยชน์หรือมีโทษ มันไม่ได้มีประโยชน์และไม่มีโทษด้วยตัวของมันเอง แต่มันอยู่ที่วิธีการใช้งานของมนุษย์ ถ้าใช้ดีไปทำกับข้าวก็มีประโยชน์ ถ้าไปทำร้ายคนก็เป็นโทษ AI ไม่ได้ผิดอะไรนะ และมันก็ยังไม่ได้สมบูรณ์แบบอย่างที่หลายคนบอก” รณพงศ์กล่าว

กนกพร ประสิทธิ์ผล ผู้อำนวยการศูนย์พัฒนาสื่อใหม่ ไทยพีบีเอส กล่าวว่า ระยะหลังๆ มีหลายวงเสวนาที่พูดถึง AI ว่าจะทำให้เกิดประโยชน์ได้อย่างไร แต่สำหรับการพูดคุยในวันนี้ เน้นเรื่องภัยและข้อควรระวัง การรู้เท่าทัน เราพบว่าที่ผ่านมาไม่ใช่ทุกคนหรือทุกอุตสาหกรรมที่จะนำ AI มาใช้ได้ทั้งหมด ด้วยปัจจัยด้านงบประมาณ ทักษะคน ฯลฯ แต่สิ่งที่เข้าไปแทรกซึมแล้วในปัจจุบันคือการถูกนำไปใช้ในทางที่ไม่ถูกต้อง เป็นภัยกับประชาชน และสิ่งที่น่ากังวลคือความรู้เท่าทัน (Literacy) จึงอยากให้มีการเตือนเรื่องนี้ในทุกวงเสวนาที่เกี่ยวกับ AI

“หากมองในมุมกระบวนการตรวจสอบข่าว เชื่อว่าทุกกองบรรณาธิการข่าวมีการตรวจสอบอยู่แล้ว เพียงแต่ปัจจุบันมีปริมาณเพิ่มขึ้น เทคโนโลยีมีความเนียนมากขึ้น จึงต้องใช้กระบวนการตรวจสอบที่หลากหลายขึ้น สื่อต้องพัฒนาทักษะให้มากขึ้น ต้องยอมรับว่าผ่านมาก็มีเหมือนกันที่เราพลาดเอง”กนกพรกล่าว

ธนบูรณ์ สมบูรณ์ ผู้ก่อตั้งเครือข่ายพลเมืองสร้างสรรค์สังคม Creative Citizen กล่าวว่า เข้าไปสนใจเรื่องของ AI ในฐานะผู้ใช้งาน ตามกระแสที่บอกว่า “ใครใช้ AI ไม่เป็นระวังจะโดนแย่งงาน”หลังจากไปอบรมก็ได้รับมุมมองว่า AI ก็เหมือนม้าเร็ว หากควบคุมมันได้เราจะสามารถขี่มันไปได้ไกลและเร็วขึ้น แต่หากควบคุมไม่ดีหรือเชื่อมากเกินไปก็อาจถูกสะบัดตกจากม้าบาดเจ็บได้ ดังนั้นจะต้องมีการตรวจสอบซ้ำ (Recheck) ไม่ได้เชื่อตั้งแต่แรก ในฐานะผู้บริโภคต้องมีความตระหนักกันมากขึ้นเทคโนโลยีเป็นของดี แต่เราใช้มันอย่างระมัดระวัง

อย่างเมื่อเร็วๆ นี้ ในสื่อสังคมออนไลน์มีการแชร์ภาพรถยนต์ยี่ห้อมิตซูบิชิทรงกลมดูน่ารัก แต่ผ่านไปไม่กี่วัน ทราบว่าเป็นภาพจากบัญชีทวิตเตอร์ในประเทศญี่ปุ่นที่ใช้ AI ทำขึ้นมา ซึ่งก่อนหน้านั้นตนได้แชร์ให้เพื่อนไปแล้วถึง 7 คน แต่หลังจากนั้นก็มีการตรวจสอบจนพบว่าเป็นของปลอม ต้องยอมรับว่าเรื่องนี้ตรวจสอบได้ยาก อย่างมิจฉาชีพโทรศัพท์มาหลอกแอบอ้างเรื่องต่างๆ ยังพอจับสังเกตได้ เช่น สำเนียงการพูดแปลกๆ สัญญาณเสียงไม่ชัด แต่พอเป็นภาพที่เผยแพร่ทางสื่อสังคมออนไลน์นั้นเหมือนมากจนแยกแยะได้ลำบาก

สุวิตา จรัญวงศ์ ผู้ก่อตั้ง และ CEO, Tellscoreกล่าวว่า การทำงานของ Tellscore ที่ดูแลอินฟลูเอนเซอร์กว่า 1 แสนคน แผนงานในปี 2567 เบื้องต้นการยืนยันตัวตนด้วยบัตรประชาชน (KYC) ทำอยู่แล้ว แต่เมื่อ AI เข้ามา ก็ต้องทำมากขึ้น โดยจะให้นโยบายว่า อินฟลูเอนเซอร์คนใดผลิตเนื้อหาโดยใช้ AI ไม่ว่าทั้งหมดหรือผสมผสาน ขอให้แจ้งผู้รับสาร

ที่ผ่านมาพบว่าแม้แต่อินฟลูเอนเซอร์ก็ยังถูกหลอก ดังนั้นในฐานะที่เป็นหน่วยงานเล็กๆ ไม่มีคำตอบ แต่มีข้อสังเกตที่ 3 ส่วน คือ ผู้ใช้งานต้องมีสติ หน่วยงานรับแจ้งเรื่องร้องเรียนอาจมีมากขึ้น และสุดท้ายคือรัฐต้องมีกฎ กติกาเกี่ยวกับเรื่องนี้

“คนทำผิดกฎหมายเขาอาจไม่ได้ระบุออกมาว่านี่คือ AI ปัญหาที่มันเกิดเพราะเราไม่รู้ว่ามันไม่จริง เราไมได้กล่าวหาว่า AI มันไม่ดีทั้งหมด แต่มันปนมากับความจริง คนก็เลยกลัว แต่ถ้าเราเริ่มแยกออกได้มากขึ้น สิ่งที่ไม่ได้ Label มันจะต้องน่าสงสัยแล้ว ก็คือกลไกทั้ง 3 ตั้งแต่ตัวเราเอง หน่วยงานรับร้องเรียน หรือกติกาทางสังคม ก็น่าจะช่วยกันดูแลได้ดีขึ้น” สุวิตา กล่าว

ในช่วงท้ายของงาน ยังมีกิจกรรม แนะนำโครงการ TikTok Safety Day ร่วมกับภาคีโคแฟค (ประเทศไทย) โดย ชนิดา คล้ายพันธ์ Head of Public Policy, TikTok Thailand กล่าวว่า TikTok ทำงานกับโคแฟคในเรื่องต่อสู้กับข้อมูลที่สร้างความเข้าใจผิด (Misinformation) จนปัจจุบันเป็นปีที่ 3 แล้ว มีหัวข้อรณรงค์ตั้งแต่ พื้นที่ปลอดภัยในการไถฟีด , โปรดใช้วิจารณญาณในการไถฟีด ล่าสุดคือ พื้นที่ปลอดภัยเพื่อทุกการสร้างสรรค์ ซึ่งต้องการให้ทั้งผู้ใช้งาน ผู้ผลิตเนื้อหา และพันธมิตรต่างๆ ช่วยกันผลิตเนื้อหาเพื่อเตือนใจผู้ใช้ TikTok

สำหรับช่วงท้าย ได้รับเกียรติจากอาจารย์ชมัยภร บางคมบาง ศิลปินแห่งชาติ สาขาวรรณศิลป์ประจำปี 2557 สรุปเนื้อหาการเสวนาทั้งหมดออกมาเป็นบทกวี เอไอ vs มนุษย์ ใครเป็นตัวร้าย และประโยชน์ของ AI

-/-/-/-/-/-/-/-/-/-/-